DLI Flink Jobs

Создание задания Flink SQL

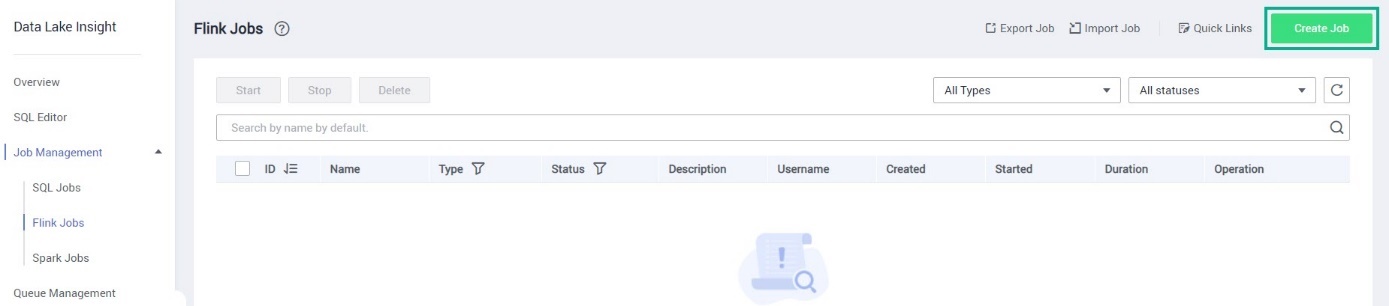

В списке сервисов выберите Data Lake Insight.

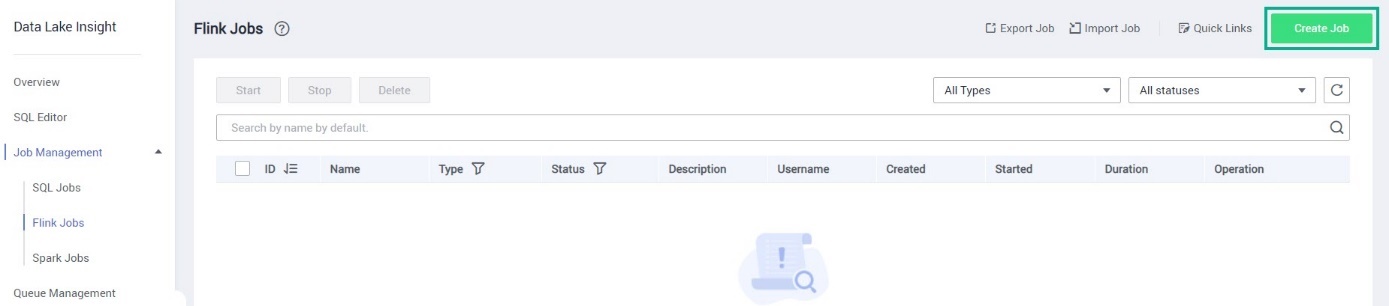

В боковом меню слева выберите Job Management → Flink Jobs.

Нажмите Create Job.

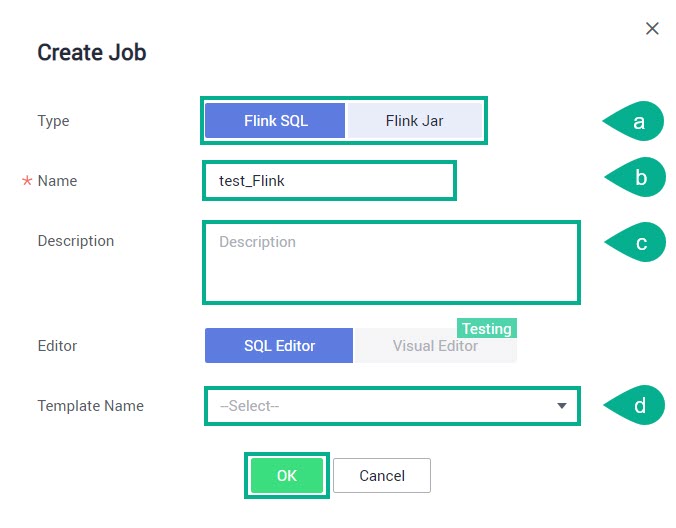

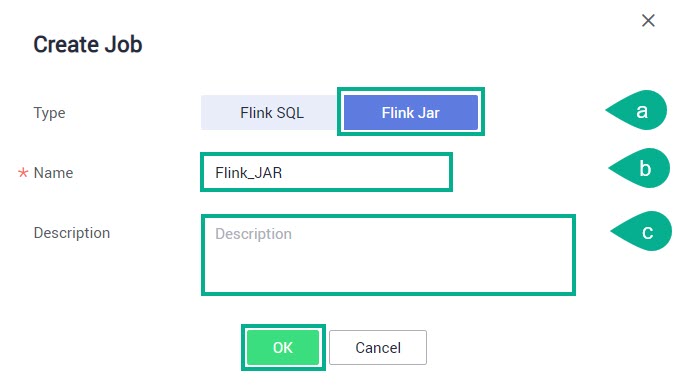

В данном окне заполните следующие поля и нажмите ОК:

Type — можно выбрать один из типов задания:

Flink SQL — выберите данный тип для создания потокового задания Flink SQL. Задания Flink SQL поддерживают разработку запросов Flink SQL с помощью редактора SQL.

Flink Jar — данный тип задания для выполнения вторичной разработки на основе API Flink. Нужно создать JAR-файл и отправить этот файл в DLI.

См.такжеПодробнее смотрите в разделе Создание задания Flink JAR.

Name — укажите имя задания.

Description — введите описание.

Template Name (только для Flink SQL) — можно выбрать один из системных или пользовательских шаблонов. Для его выбора начинайте вводить его наименование (или его часть).

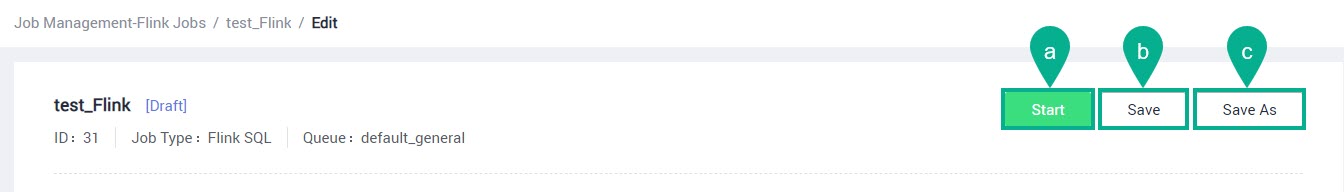

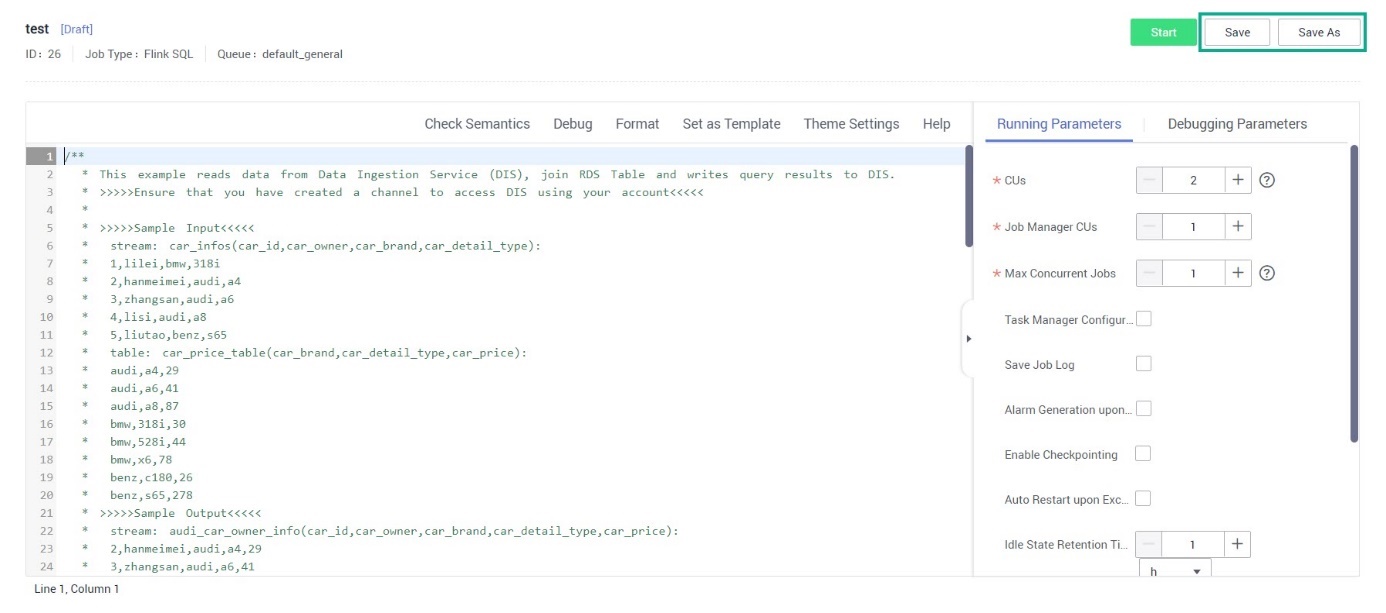

Вы перейдете на страницу создания задания. Введите или вставьте код в окно редактора.

Для сохранения задания доступны следующие опции:

Start — запуск задания. В новом окне нажмите Start Now и задание будет создано и запущено.

Save — сохранение произведенных изменений.

Save As — сохранить текущий вариант в новом задании. В новом окне в поле Name укажите имя нового задания, в поле Description — описание задание и нажмите ОК.

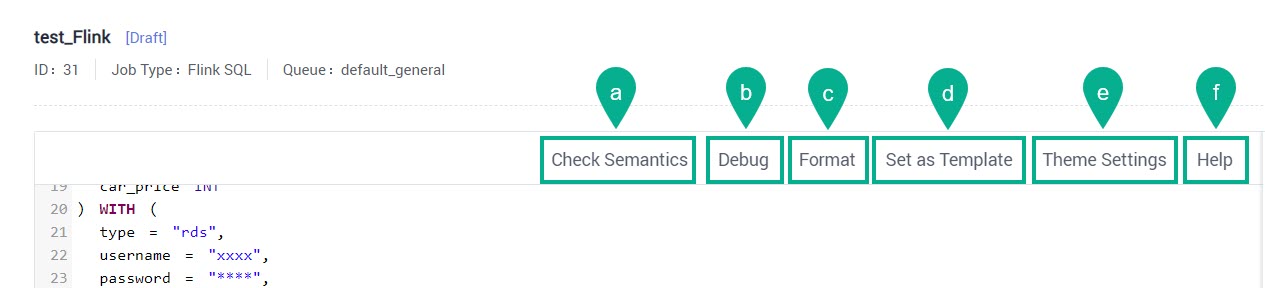

Для работы с кодом доступны следующие опции:

Check Semantics — отлаживать или запускать задание можно только после успешной семантической проверки.

При успешно завершенной проверке появится сообщение «The SQL semantic verification is complete. No error.».

Если проверка завершится неудачно, то перед строками с ошибками отобразится красная метка

.

Для просмотра ошибки подведите курсор к данной метке.

.

Для просмотра ошибки подведите курсор к данной метке.Debug — функция отладки заданий помогает проверить логическую корректность SQL запроса перед запуском задания.

Format — форматирование SQL запросов в окне редактирования.

Set as Template — сохранить текущий вариант в качестве шаблона. В новом окне в поле Name укажите имя шаблона, в поле Description — описание задания и нажмите ОК.

Theme Settings — установите связанные с темой параметры, включая размер шрифта, wrap и стиль страницы (темная или светлая тема).

Help — подборка статей в Help Center по синтаксису SQL.

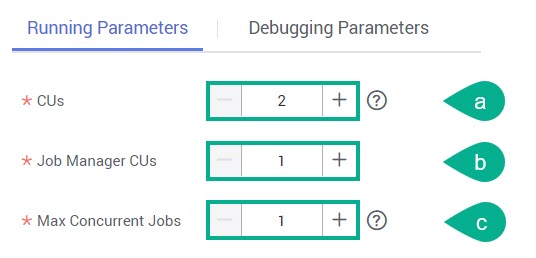

Можно настроить следующие параметры в окне справа на вкладке Running Parameters:

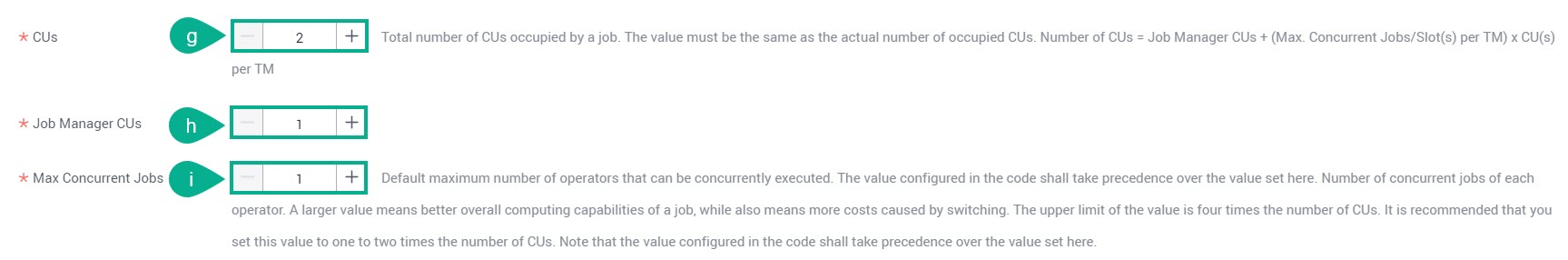

CUs — укажите количество вычислительных единиц (CU). Один CU состоит из 1 vCPU и 4 ГБ памяти.

Job Manager CUs — укажите количество CU блока управления.

Max Concurrent Jobs — укажите максимальное количество выполняемых одновременно заданий Flink SQL.

ПримечаниеВерхний предел этого значения в четыре раза больше числа CU (CUs — Job Management CUs). Рекомендованное значение — в один-два раза больше числа CU. Обратите внимание, что значение, настроенное в коде, должно иметь приоритет над значением, установленным в данном поле.

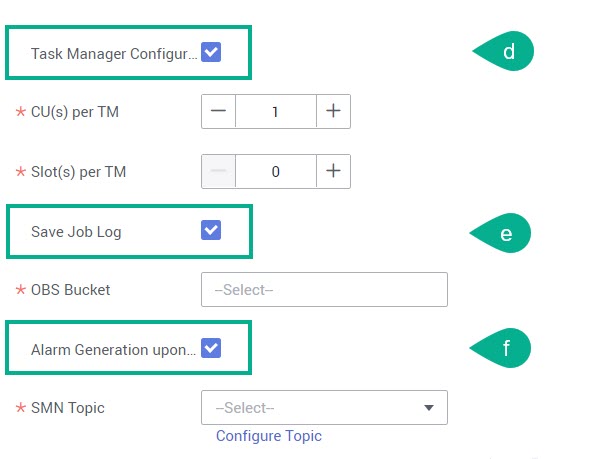

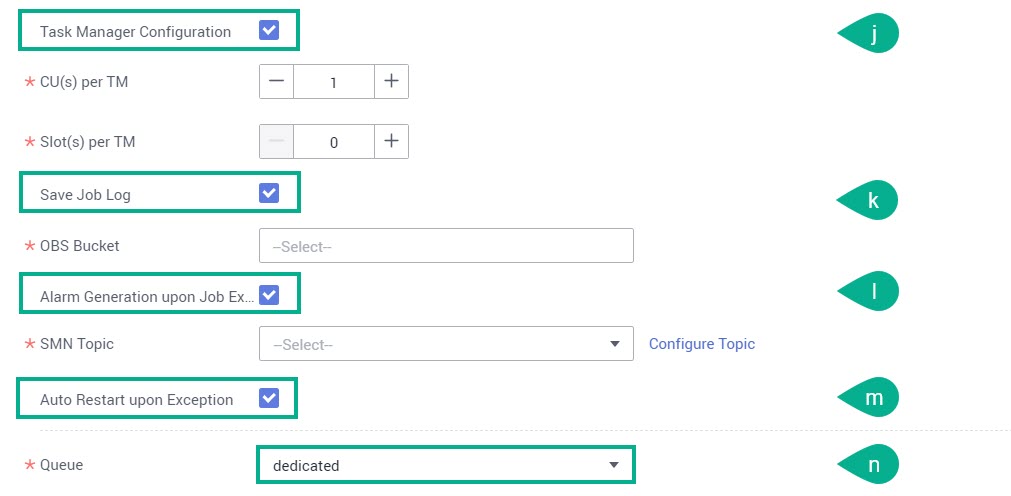

Task Manager Configuration — включите опцию, если нужно установить параметры ресурсов Диспетчера задач (Task Manager), такие как:

CU(s) per TM — количество ресурсов, занятых каждым Диспетчером задач.

Slot(s) per ТМ — количество слотов, содержащихся в каждом Диспетчере задач.

Save Job Log — включите опцию, если нужно сохранять журналы выполнения задания в бакете OBS. В этом случае укажите бакет OBS для хранения журналов. Если бакет не авторизован, появится соответствующее сообщение — нажмите Authorize → ОК.

Alarm Generation upon Job Exception — включите опцию, если нужно направлять сообщение об ошибках при выполнении заданий по электронной почте. Выберите из списка тему SMN. Если нужной темы нет, нажмите Configure Topic.

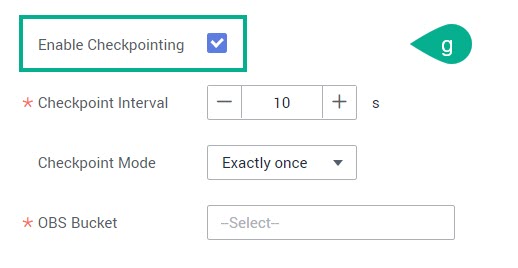

Enable Checkpointing — включите опцию, чтобы настроить создание снимков (snapshots) заданий. Если эта функция включена, задания могут быть восстановлены на определенные моменты времени (checkpoints).

Укажите следующие параметры:

Checkpoint Interval — это количество секунд между созданием новых контрольных точек (checkpoints). Укажите значение параметра от 1 до 999999. Значение по умолчанию — 10.

Checkpoint Mode — можно выбрать на одно из следующих значений: «At least once» (события обрабатываются минимум один раз) или «Exactly once» (события обрабатываются только один раз).

OBS Bucket — выберите бакет OBS для хранения контрольных точек (checkpoints). Если бакет не авторизован, то появится соответствующее сообщение — нажмите Authorize → ОК.

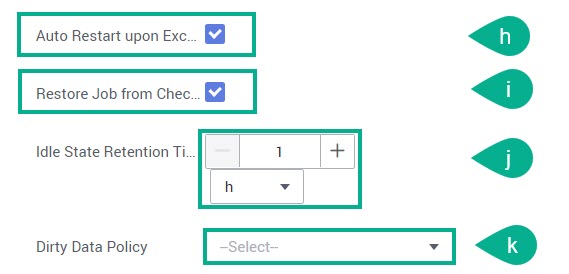

Auto Restart upon Exception — включите опцию, если нужна автоматическая перезагрузка в случае ошибок в задании.

Это также позволит включить восстановление задания из контрольной точки (выберите Restore Job from Checkpoint, но только при включенной опции Enable Checkpointing).

Idle State Retention Time — выберите время без обновления статуса. Значение по умолчанию — 1 hour.

Dirty Data Policy — выберите из списка политику обработки измененных данных. Поддерживаются следующие виды политик: «Ignore», «Trigger a job exception» и «Save».

ПримечаниеПри выборе «Save» измененные данные будут храниться в бакете OBS, указанном выше.

Queue — выберите из списка нужную очередь. По умолчанию выбрана «Shared queue».

При выборе пользовательской очереди нужно указать JAR-пакет в поле UDF Jar. Чтобы пакет появился в списке он должен быть загружен в бакет OBS через раздел Data Management → Package Management.

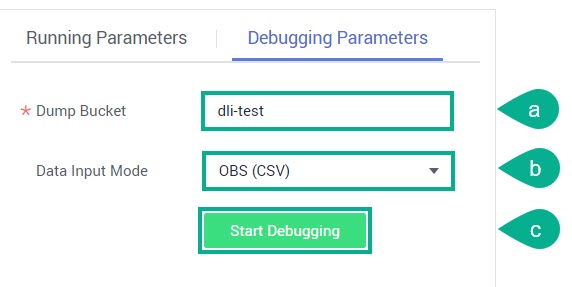

Можно также настроить следующие параметры в окне справа на вкладке Debugging Parameters

Dump Bucket — выберите бакет OBS для хранения журналов отладки. Если бакет не авторизован, то появится соответствующее сообщение — нажмите Authorize → ОК.

Data Input Mode — выберите одно из значений: «OBS (CSV)» или «Manual typing».

Start Debugging — нажмите кнопку для начала процедуры отладки.

Создание задания Flink JAR

В списке сервисов выберите Data Lake Insight.

В боковом меню слева выберите Job Management → Flink Jobs.

Нажмите Create Job.

В данном окне заполните следующие поля и нажмите ОК:

Type — можно выбрать один из типов задания:

Name — укажите имя задания.

Description — введите описание.

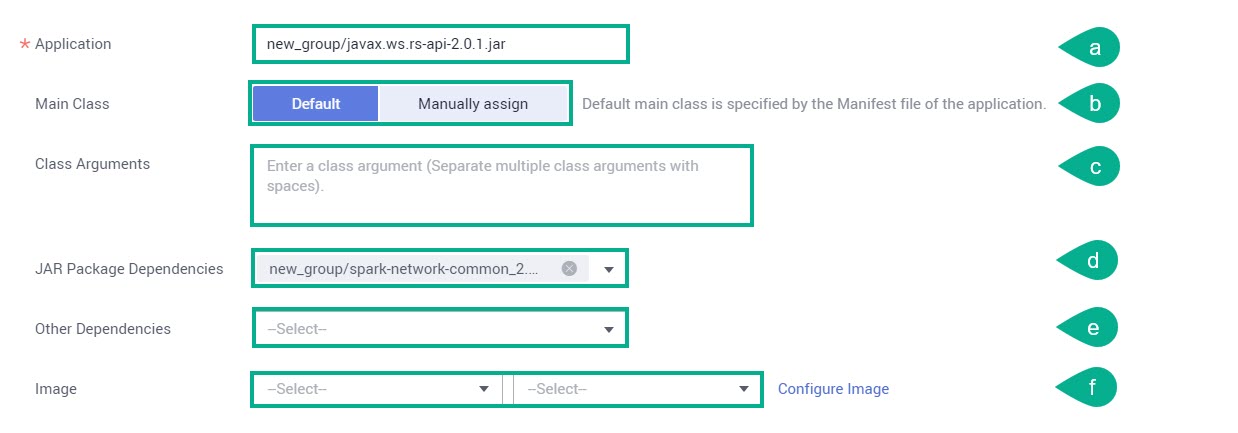

Вы перейдете на страницу создания задания. Заполните следующие поля и нажмите Start, Save или Save As.

Application — выберите или создайте пакет с приложением.

Main Class — оставьте класс по умолчанию (Default) или укажите в поле Class Name имя главного класса (Manually assign).

Class Arguments — перечислите через пробел аргументы указанного класса.

JAR Package Dependencies — выберите из списка JAR-файл.

Other Dependencies — выберите из списка нужный файл.

Image — выберите из списка образ и его версию. Если нужного образа нет, то загрузите его через сервис SWR — нажмите Configure Image.

CUs — укажите количество вычислительных единиц (CU). Один CU состоит из 1 vCPU и 4 ГБ памяти.

Job Manager CUs — укажите количество CU блока управления.

Max Concurrent Jobs — укажите максимальное количество выполняемых одновременно заданий Flink SQL.

ПримечаниеВерхний предел этого значения в четыре раза больше числа CU (CUs — Job Management CUs). Рекомендованное значение — в один-два раза больше числа CU. Обратите внимание, что значение, настроенное в коде, должно иметь приоритет над значением, установленным в данном поле.

Task Manager Configuration — включите опцию, если нужно установить параметры ресурсов Диспетчера задач (Task Manager), такие как:

CU(s) per TM — количество ресурсов, занятых каждым Диспетчером задач.

Slot(s) per ТМ — количество слотов, содержащихся в каждом Диспетчере задач.

Save Job Log — включите опцию, если нужно сохранять журналы выполнения задания в бакете OBS. В этом случае укажите бакет OBS для хранения журналов. Если бакет не авторизован, появится соответствующее сообщение — нажмите Authorize → ОК.

Alarm Generation upon Job Exception — включите опцию, если нужно направлять сообщение об ошибках при выполнении заданий по электронной почте. Выберите из списка тему SMN. Если нужной темы нет, нажмите Configure Topic.

Auto Restart upon Exception — включите опцию, если нужна автоматическая перезагрузка в случае ошибок в задании.

Queue — выберите из списка нужную очередь.

ПримечаниеЗадания Flink JAR могут использовать только очереди общего назначения (For general purpose).

Управление разрешениями на задания Flink

В списке сервисов выберите Data Lake Insight.

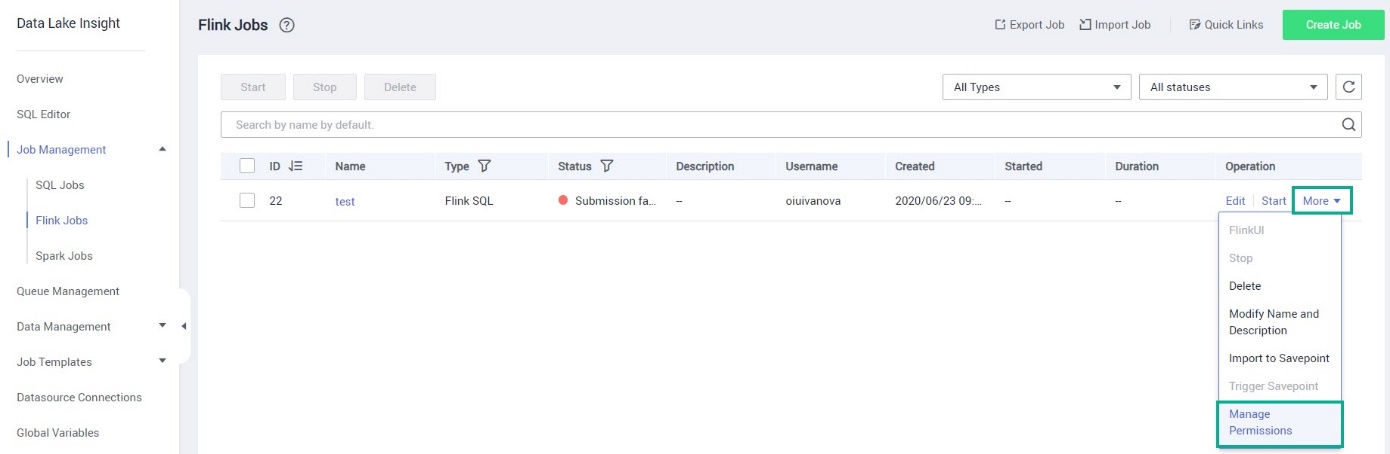

В области навигации слева выберите Job Management → Flink Jobs.

В строке с нужным заданием нажмите More и выберите из списка Manage Permissions.

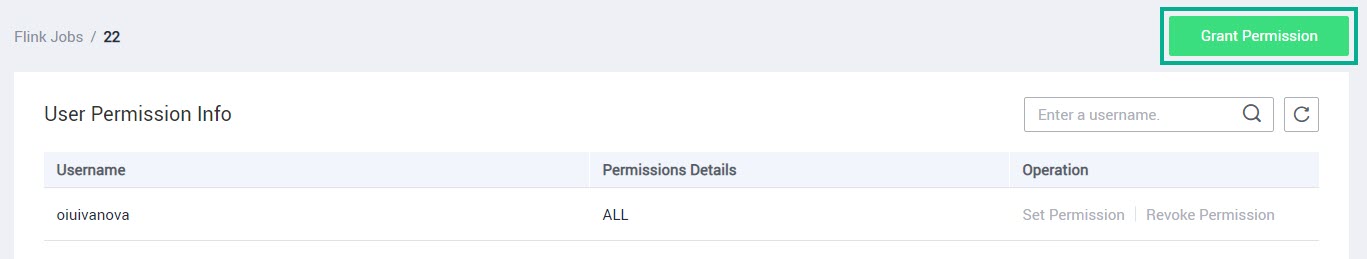

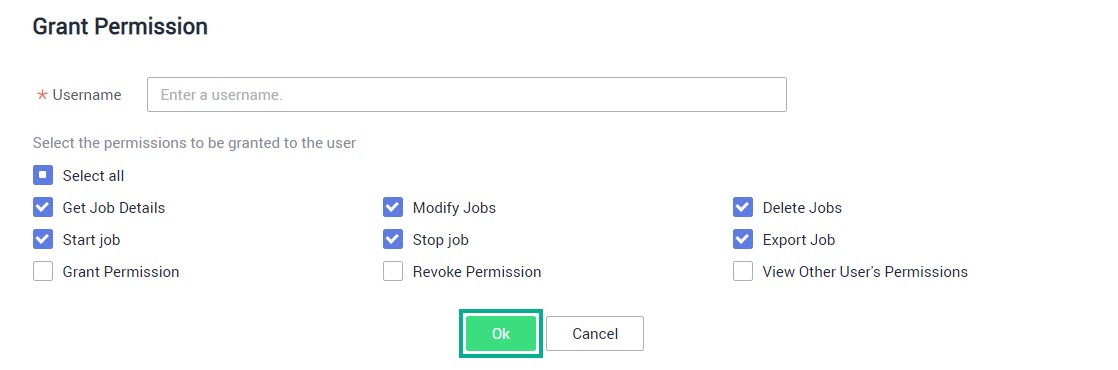

Для выдачи разрешения нажмите Grant Permission.

В поле Username введите имя нужного пользователя и выберите операции, на которые даете разрешение, и нажмите ОК.

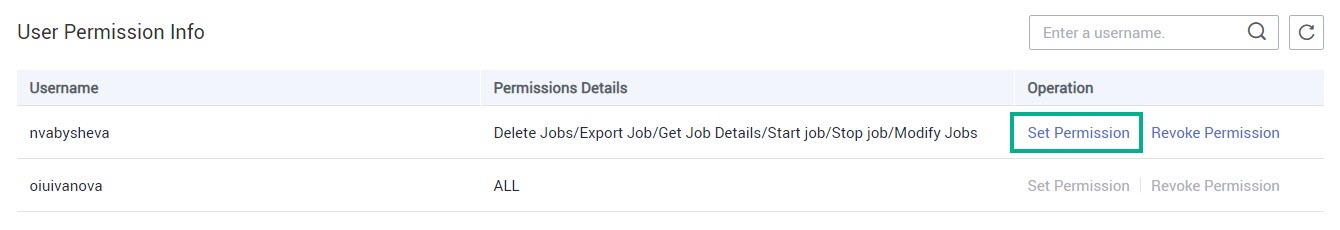

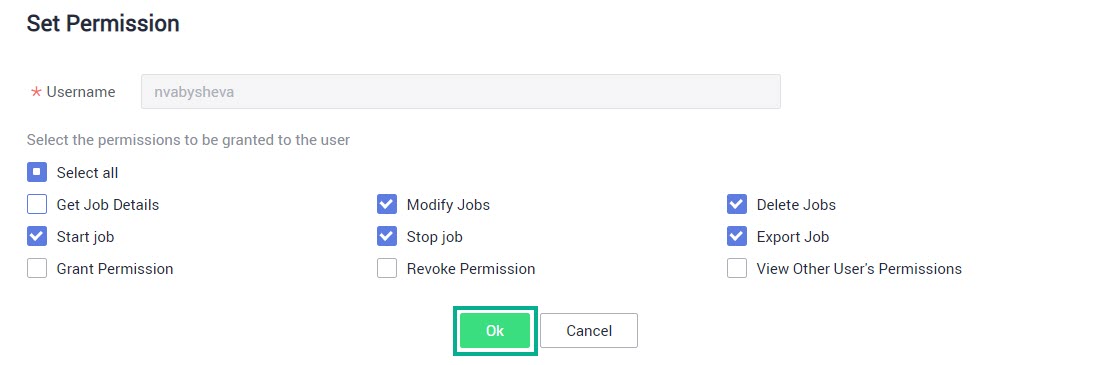

Для изменения разрешения в строке с нужным пользователем нажмите Set Permission.

Выберите операции и нажмите ОК.

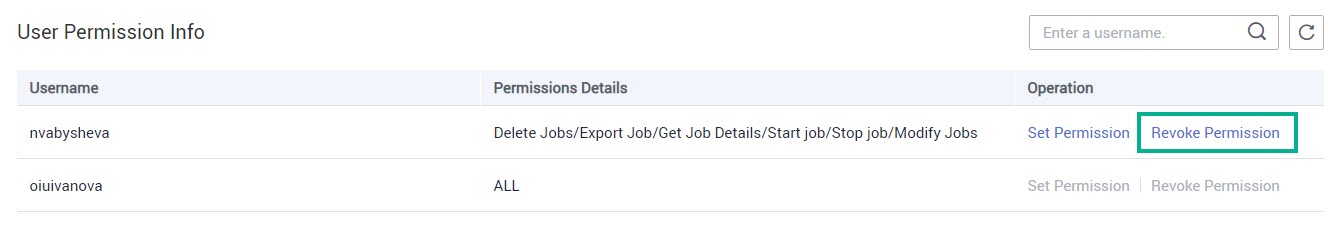

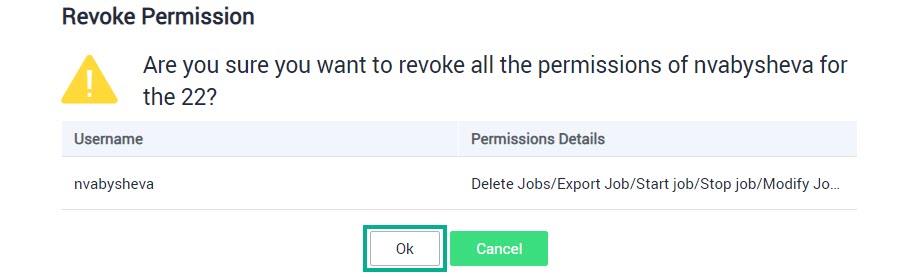

Для отзыва разрешений в строке с пользователем нажмите Revoke Permission.

Нажмите ОК.

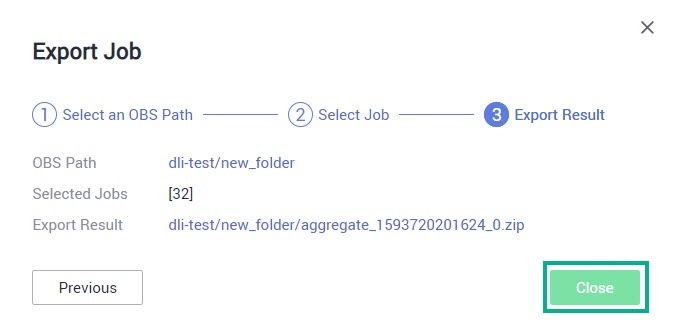

Экспорт заданий Flink

В списке сервисов выберите Data Lake Insight.

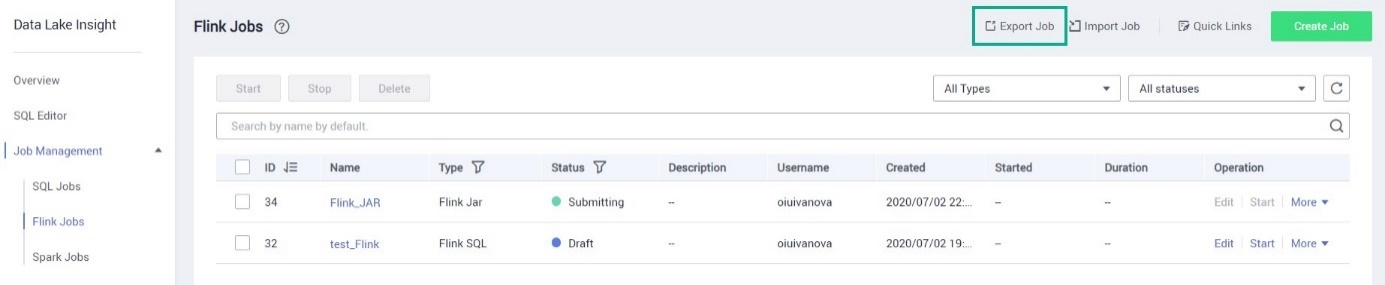

В области навигации слева выберите Job Management → Flink Jobs.

В правом верхнем углу экрана нажмите Export Job.

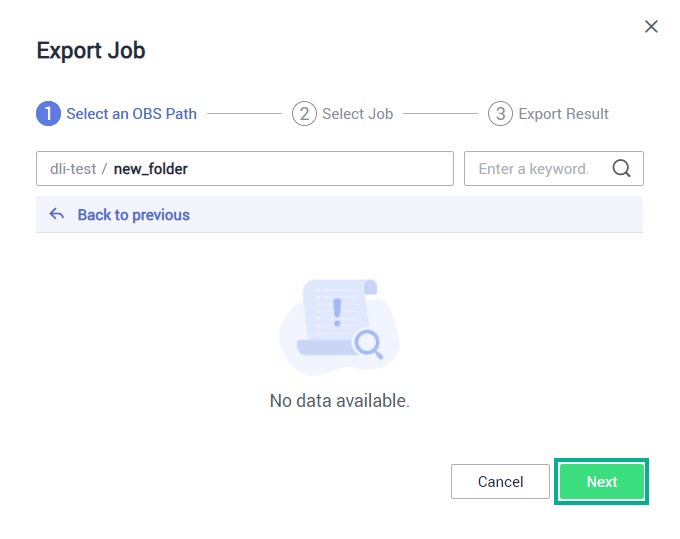

Выберите бакет и папку (при необходимости), в которую будет выгружено задание. Нажмите Next.

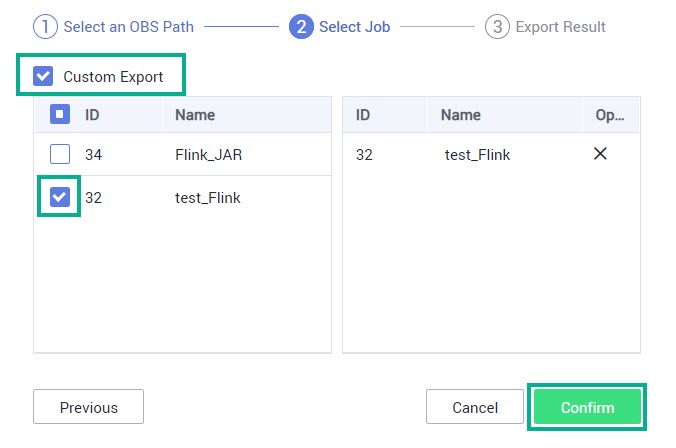

Активируйте чекбокс Custom Export и выберите задания к экспорту. Нажмите Confirm.

В окне будет представлен результат экспорта задания. Нажмите Close. Архив можно скачать из указанного пути в сервисе Object Storage Service.

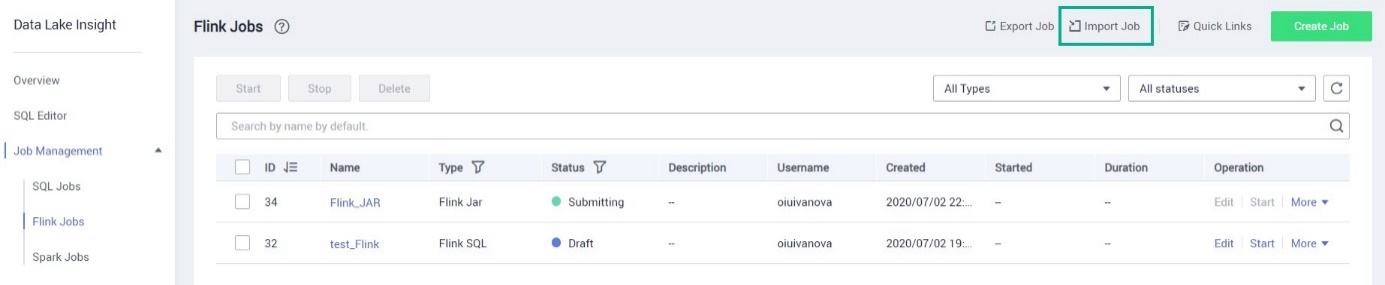

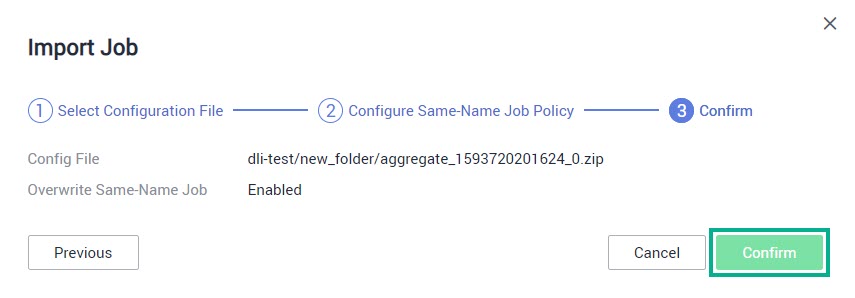

Импорт заданий Flink

В списке сервисов выберите Data Lake Insight.

В области навигации слева выберите Job Management → Flink Jobs.

В правом верхнем углу экрана нажмите Import Job.

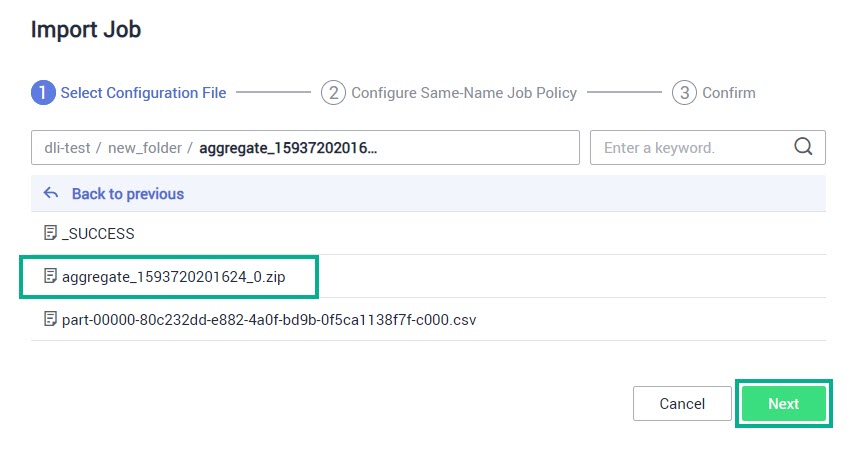

Выберите путь к файлу в бакете OBS, который будет загружен в сервис DLI. Нажмите Next.

Примечание

ПримечаниеМожно импортировать только ZIP-файл экспортированный в OBS ранее.

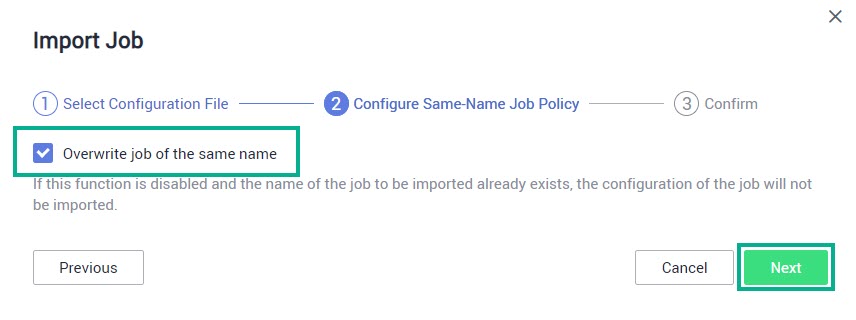

Выберите Overwrite job of the same name для перезаписи задания, если данное задание с подобным именем есть в списке. Нажмите Next.

Подтвердите импорт задания — нажмите Confirm.

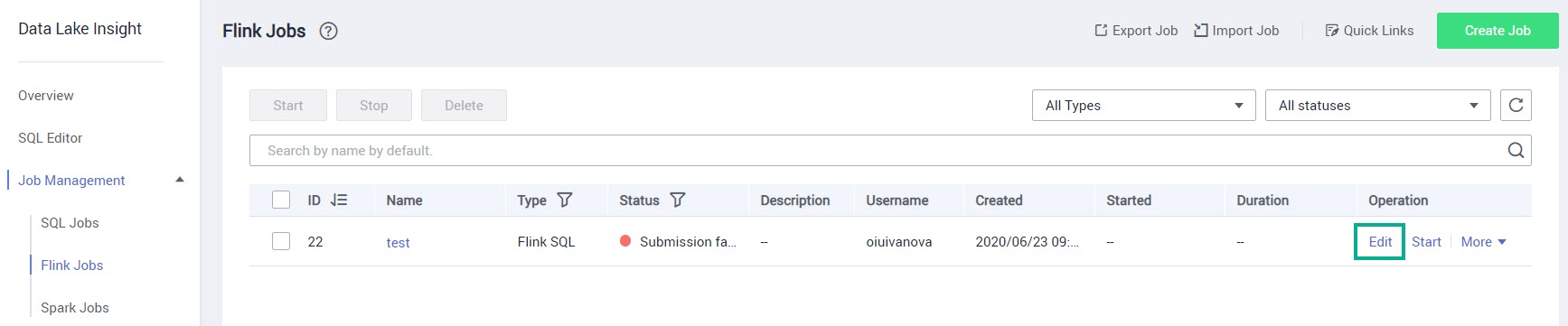

Изменение задания Flink

В списке сервисов выберите Data Lake Insight.

В области навигации слева выберите Job Management → Flink Jobs.

В строке с нужным заданием нажмите Edit.

На странице редактирования можно изменить код задания и выполнить операции аналогичные при создании задания Flink. После внесения изменений нажмите Save или Save as (для сохранения копии данного задания).

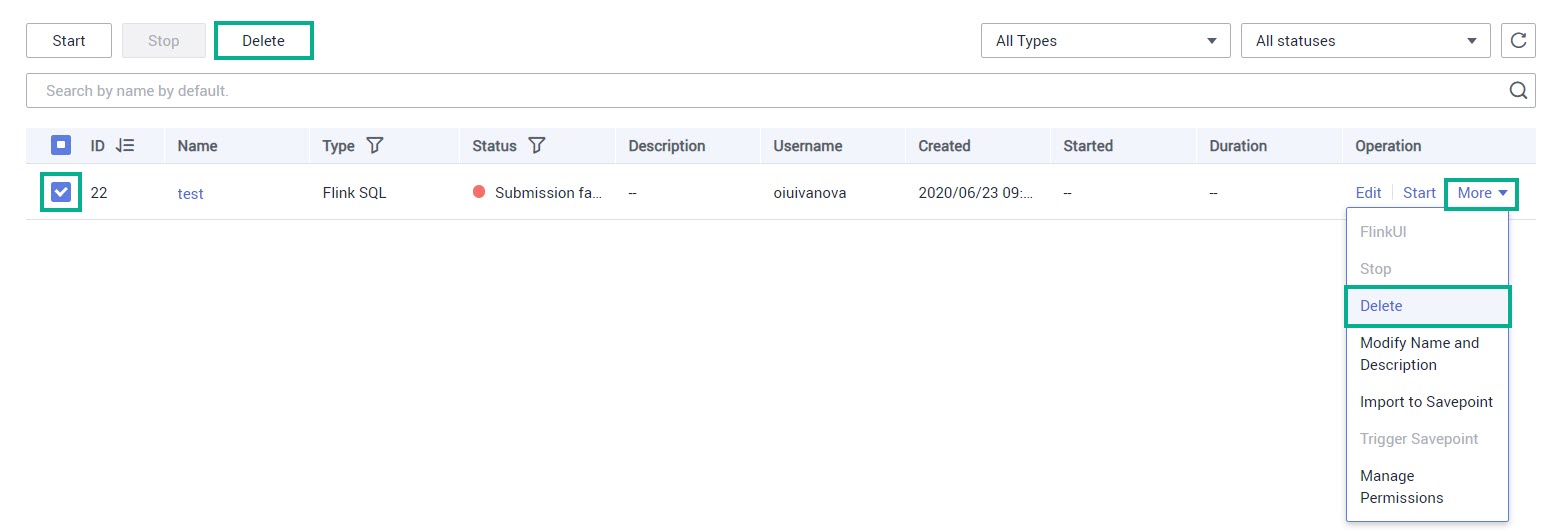

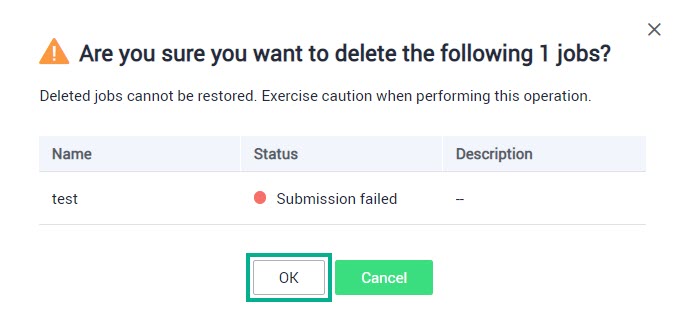

Удаление задания Flink

В списке сервисов выберите Data Lake Insight.

В области навигации слева выберите Job Management → Flink Jobs.

Выберите нужное задание и нажмите Delete или в строке с нужным заданием нажмите More и выберите из списка Delete.

Нажмите ОК.

- Создание задания Flink SQL

- Создание задания Flink JAR

- Управление разрешениями на задания Flink

- Экспорт заданий Flink

- Импорт заданий Flink

- Изменение задания Flink

- Удаление задания Flink