С помощью этого руководства вы последовательно создадите три типа инференса в ML Inference для использования их в базе знаний Managed RAG, затем проверите работоспособность базы знаний.

Вы будете использовать следующие сервисы:

Evolution Managed RAG — сервис для создания и управления базами знаний, используемыми при генерации ответов языковыми моделями.

Evolution Object Storage — объектное хранилище для размещения документов, из которых будет формироваться база знаний.

Evolution ML Inference — сервис для запуска ML-моделей в облаке.

Huggingface — платформа для публикации и использования моделей машинного обучения.

Шаги:

Перед началом работы

-

Если вы уже зарегистрированы, войдите под своей учетной записью.

Убедитесь, что в личном кабинете Cloud.ru подключены сервисы Managed RAG, ML Inference, Object Storage.

Скачайте текстовый файл faq_products.txt.

1. Создайте бакет и загрузите файл

-

Укажите название бакета, например rag-inference-bucket. Остальные параметры оставьте по умолчанию.

Нажмите Создать.

Создайте папку в бакете со следующими параметрами:

Перейдите в бакет rag-inference-bucket.

Нажмите Создать папку.

Укажите название rag-inference-kb/ и нажмите Создать.

Загрузите папку текстовый файл faq_products.txt.

2. Получите токен Huggingface

Войдите или зарегистрируйтесь на https://huggingface.co.

Перейдите в раздел Access Tokens.

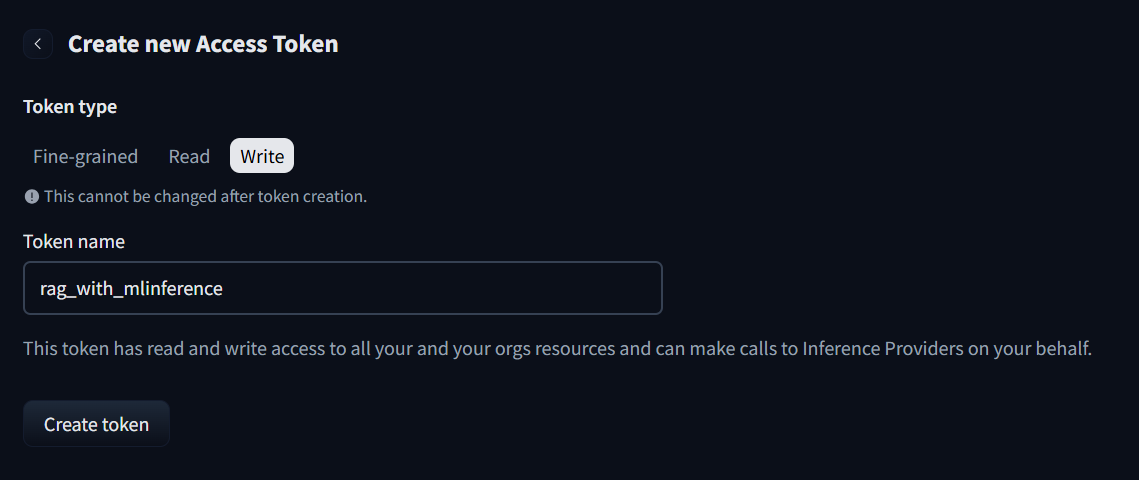

Нажмите Create new token.

Выберите тип Write.

Введите название токена, например rag_with_mlinference.

Нажмите Create token.

Скопируйте токен и сохраните его, например в блокнот. После закрытия страницы он будет недоступен.

3. Создайте инференс для модели-эмбеддера

Инференс создаетcя на примере модели с Huggingface Qwen/Qwen3-Embedding-0.6B.

Перейдите в личный кабинет Cloud.ru, AI Factory → ML Inference.

На вкладке Model RUN нажмите Создать.

Укажите название embedder-for-rag.

Выберите для Runtime значение vLLM.

Добавьте модель.

Нажмите Добавить из Hugging Face.

В поле Репозиторий с моделью Hugging Face вставьте скопированное название модели Qwen/Qwen3-Embedding-0.6B.

Нажмите Добавить токен в Secret Management, если токен еще не добавлен.

Укажите путь, например rag_with_mlinferece.

Введите описание, например Huggingface access token.

В поле Значение секрета выберите Стандартный режим и вставьте токен Huggingface, полученный на шаге 2.

Нажмите Создать.

Токен сохранен в Secret Management. Вернитесь к созданию инференса.

В поле Токен доступа в Hugging Face выберите созданный токен rag_with_mlinferece → версия 1.

Нажмите Добавить.

Дождитесь расчета ресурсов.

В поле Задача ML модели выберите Embedding — отличительная черта инференса такого типа.

Остальные параметры оставьте по умолчанию и нажмите Продолжить.

Включите опцию Не выключать модель.

(Опционально) Настройте масштабирование.

(Опционально) В настройке Аутентификация выберите сервисный аккаунт.

(Опционально) В настройке Логирование укажите лог‑группу.

Нажмите Создать.

Дождитесь, когда инференс перейдет в статус «Запущен».

Перейдите на вкладку Информация и скопируйте идентификатор инференса — часть публичного URL между https:// и .modelrun.

Например, в публичном URL https://12345c60-xxx-4527-xxxx-f789f789fb11.modelrun.inference.cloud.ru нужный идентификатор — 12345c60-xxx-4527-xxxx-f789f789fb11.

4. Создайте инференс для модели-реранкера

Инференс создаетcя на примере модели с Huggingface Qwen/Qwen3-Reranker-0.6B.

Перейдите в личный кабинет Cloud.ru, AI Factory → ML Inference.

На вкладке Model RUN нажмите Создать.

Укажите название reranker-for-rag.

Выберите для Runtime значение vLLM.

Добавьте модель.

Нажмите Добавить из Hugging Face.

В поле Репозиторий с моделью Hugging Face вставьте скопированное название модели Qwen/Qwen3-Reranker-0.6B.

Нажмите Добавить токен в Secret management, если токен еще не добавлен.

Укажите путь, например rag_with_mlinferece.

Введите описание.

В поле Значение секрета выберите Стандартный режим и вставьте токен Huggingface, полученный на шаге 2.

Нажмите Создать.

Токен сохранен в Secret Management. Вернитесь к созданию инференса.

В поле Токен доступа в Hugging Face выберите созданный токен rag_with_mlinferece → версия 1.

Нажмите Добавить.

Дождитесь расчета ресурсов.

В поле Задача ML модели выберите Score — отличительная черта инференса такого типа.

Остальные параметры оставьте по умолчанию и нажмите Продолжить.

Включите опцию Не выключать модель.

(Опционально) Настройте масштабирование.

(Опционально) В настройке Аутентификация выберите сервисный аккаунт.

(Опционально) В настройке Логирование укажите лог‑группу.

Нажмите Создать.

Дождитесь, когда инференс перейдет в статус «Запущен».

Перейдите на вкладку Информация и скопируйте идентификатор инференса — часть публичного URL между https:// и .modelrun.

Например, в публичном URL https://12345c60-xxx-4527-xxxx-f789f789fb11.modelrun.inference.cloud.ru нужный идентификатор — 12345c60-xxx-4527-xxxx-f789f789fb11.

5. Создайте инференс для LLM

Инференс создаетcя на примере модели с Huggingface t-tech/T-lite-it-1.0.

Перейдите в личный кабинет Cloud.ru, AI Factory → ML Inference.

На вкладке Model RUN нажмите Создать.

Укажите название llm-for-rag.

Выберите для Runtime значение vLLM.

Добавьте модель.

Нажмите Добавить из Hugging Face.

В поле Репозиторий с моделью Hugging Face вставьте скопированное название модели t-tech/T-lite-it-1.0.

Нажмите Добавить токен в Secret Management, если токен еще не добавлен.

Укажите путь, например rag_with_mlinferece.

Введите описание.

В поле Значение секрета выберите Стандартный режим и вставьте токен Huggingface, полученный на шаге 2.

Нажмите Создать.

Токен сохранен в Secret Management. Вернитесь к созданию инференса.

В поле Токен доступа в Hugging Face выберите созданный токен rag_with_mlinferece → версия 1.

Нажмите Добавить.

Дождитесь расчета ресурсов.

В поле Задача ML модели выберите Generate — отличительная черта инференса такого типа.

Остальные параметры оставьте по умолчанию и нажмите Продолжить.

Включите опцию Не выключать модель.

(Опционально) Настройте масштабирование.

(Опционально) В настройке Аутентификация выберите сервисный аккаунт.

(Опционально) В настройке Логирование укажите лог‑группу.

Нажмите Создать.

Дождитесь, когда инференс перейдет в статус «Запущен».

Перейдите на вкладку Информация и скопируйте идентификатор инференса — часть публичного URL между https:// и .modelrun.

Например, в публичном URL https://12345c60-xxx-4527-xxxx-f789f789fb11.modelrun.inference.cloud.ru нужный идентификатор — 12345c60-xxx-4527-xxxx-f789f789fb11.

6. Создайте базу знаний с использованием инференса

На этом шаге вы создадите базу знаний на основе загруженных документов и проиндексируете ее для использования с языковыми моделями.

В личном кабинете перейдите в AI Factory → Managed RAG.

Нажмите Создать базу знаний.

В поле Название укажите имя базы знаний, например kb-rag-with-inference.

При необходимости введите описание.

В поле Путь к папке в бакете выберите папку rag-inference-kb, в бакете Object Storage, куда вы загрузили файл faq_products.txt.

В поле Расширение файлов введите txt и выберите его.

Включите опцию Вручную настроить обработку документов и модель.

(Опционально) В настройке Аутентификация выберите сервисный аккаунт.

(Опционально) В настройке Логирование укажите лог‑группу.

Нажмите Продолжить.

Пропустите настройку экстрактора и нажмите Продолжить.

Выберите источник модели ML Inference.

В списке выберите созданный инференс embedder-for-rag.

Нажмите Создать.

Дождитесь завершения индексации базы знаний и ее версии — это займет несколько минут.

Перейдите в созданную версию базы знаний.

Скопируйте значения полей ID версии и ID базы знаний.

7. Проверьте работу базы знаний

Вы можете дополнительно проверить работу с базой знаний с помощью личного кабинета или API. Рекомендуется использовать оба способа.

Перейдите в созданную версию базы знаний.

Перейдите на вкладку Чат.

Включите опцию Использовать модель-реранкер.

В качестве источника модели‑реранкера выберите ML Inference.

Выберите созданный инференс reranker-for-rag.

В качестве Модель‑LLM выберите ML Inference и из списка выберите инференс llm-for-rag.

Отправьте сообщение в чате и получите ответ.

Что дальше

С этим руководством вы создали базу знаний на основе нескольких инференсов моделей.

Теперь можно отправлять запросы к инференсу.

Узнавайте больше о прикладных сценариях и примерах решения бизнес-задач, получайте навыки управления облаком, выполняя практические руководства.