Задание можно создать и запустить двумя способами:

Создание задания через GUI

В списке сервисов выберите MapReduce Service.

В боковом меню слева выберите Clusters → Active Clusters.

Нажмите на название кластера.

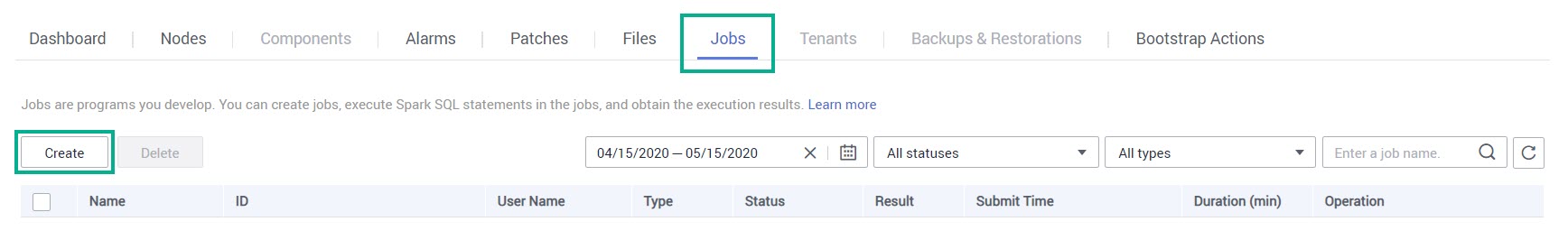

Перейдите на вкладку Jobs и нажмите Create.

Заполните следующие поля и нажмите OK:

Type — выберите тип задания «MapReduce».

Name — укажите название задания.

Program Path — нажмите OBS и выберите путь к программе hadoop-mapreduce-examples-3.1.3.jar, которую загрузили в бакет в папку «program».

Parameters — введите следующее: wordcount s3a://mrs-word/input/ s3a://mrs-word/output/, где s3a://mrs-word/input/ — путь к созданной ранее папке «input» в бакете «mrs-word», а путь с output — путь к папке бакета, в которую будет выгружен результат задания.

В таблице появится запущенное задание.

Создание задания через узел кластера

В списке сервисов выберите MapReduce Service.

В боковом меню слева выберите Clusters → Active Clusters.

Нажмите на название кластера mrs_demo.

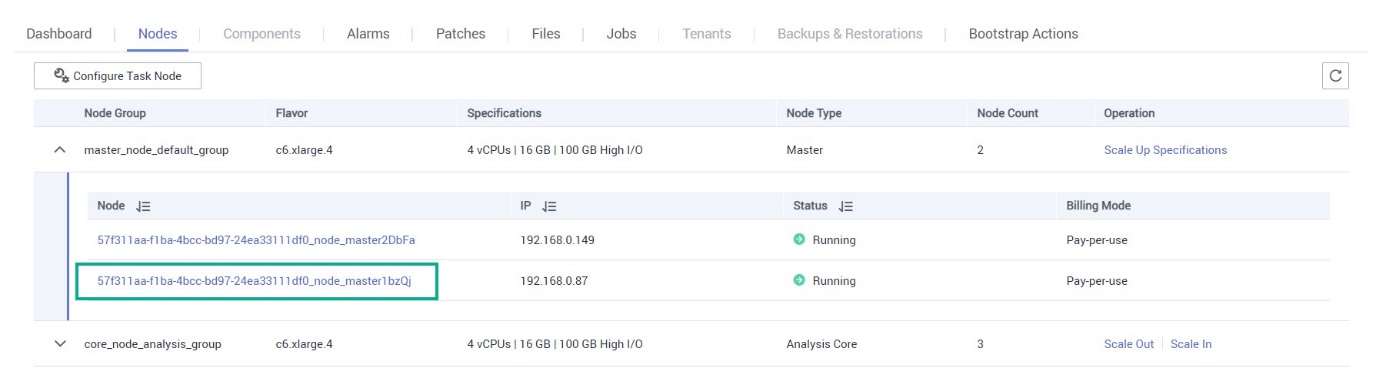

Перейдите на вкладку Nodes и раскройте master-узлы. Нажмите на название узла «node_master1».

В новом окне нажмите Remote Login.

Авторизуйтесь в узле — введите логин (root) и пароль.

Для настройки переменной среды введите команду:

source /opt/client/bigdata_env

В целях безопасности, для авторизации текущего пользователя введите команду, а затем пароль:

kinit MRS cluster username

Параметр:

MRS cluster username — логин текущего пользователя.

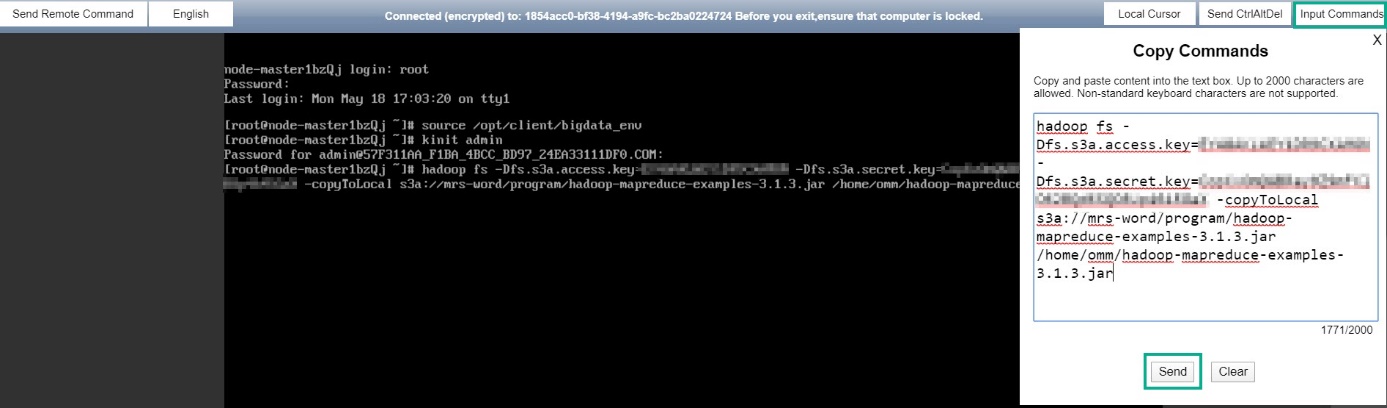

На данном шаге вам понадобятся ключи доступа AK и SK. Для копирования программы hadoop-mapreduce-examples-3.1.3.jar из бакета OBS введите следующую команду:

hadoop fs -Dfs.s3a.access.key=AK -Dfs.s3a.secret.key=SK -copyToLocal source_path.jar target_path.jarПараметры:

AK — Access Key ID.

SK — Secret Access Key.

source_path.jar — путь к программе hadoop-mapreduce-examples-3.1.3.jar в бакете OBS.

target_path.jar — путь размещения программы на узле.

Например, в нашем случае команда будет следующей (только подставьте свои ключи AK и SK):

hadoop fs -Dfs.s3a.access.key=AK -Dfs.s3a.secret.key=SK -copyToLocals3a://mrs-word/program/hadoop-mapreduce-examples-3.1.3.jar/home/omm/hadoop-mapreduce-examples-3.1.3.jarПримечаниеДля вставки команды в узел воспользуйтесь кнопкой Input Commands вставьте команду и нажмите Send.

Для создания задания введите следующую команду:

source /opt/client/bigdata_env;hadoop jar target_path wordcount -Dfs.s3a.access.key=AK -Dfs.s3a.secret.key=SK input_pathПараметры:

target_path — путь размещения программы hadoop-mapreduce-examples-3.1.3.jar на узле.

AK — Access Key ID.

SK — Secret Access Key.

input_path — путь к созданной ранее папке «input» в бакете «mrs-word».

output_path — путь к папке «output» в бакете, в которую будет выгружен результат задания.

Например, в нашем случае команда будет следующей (только подставьте свои ключи AK и SK):

source /opt/client/bigdata_env;hadoop jar /home/omm/hadoop-mapreduce-examples-3.1.3.jar wordcount -Dfs.s3a.access.key=AK -Dfs.s3a.secret.key= SK s3a://mrs-word/input/s3a://mrs-word/output/Задание запущено.