С помощью этой статьи вы авторизуетесь и отправите первый запрос к модели для генерации текста.

Для отправки запроса к текстовой модели:

Перед началом работы

-

Если вы уже зарегистрированы, войдите под своей учетной записью.

На верхней панели слева нажмите

и убедитесь в наличии сервиса Foundation Models в разделе AI Factory. Если сервиса нет в списке, обратитесь в поддержку.

Шаг 1. Создайте сервисный аккаунт

Вы можете создать сервисный аккаунт через личный кабинет.

На верхней панели слева нажмите

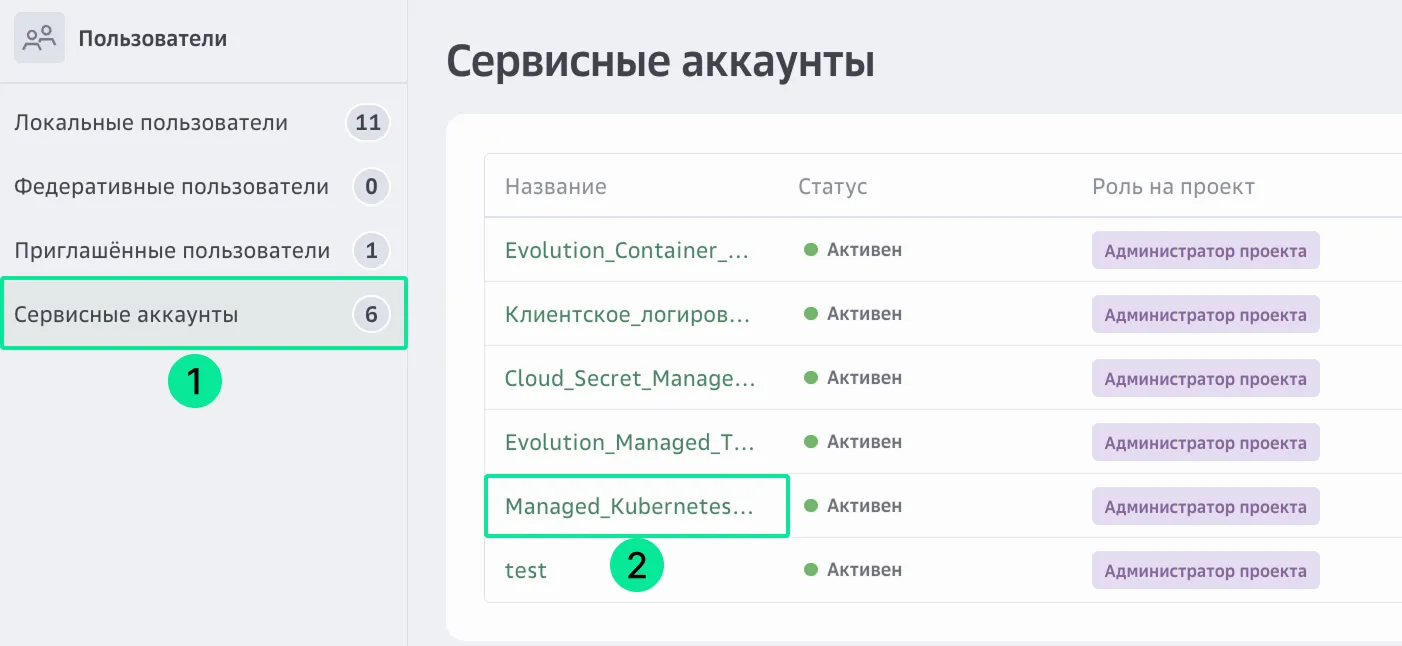

и перейдите в раздел Пользователи, на вкладку Сервисные аккаунты.

В правом верхнем углу нажмите Создать аккаунт.

Задайте для сервисного аккаунта название и описание.

Нажмите Продолжить.

Назначьте роль на проект «Администратор проекта».

Роль определяет права доступа сервисного аккаунта.

Нажмите Создать.

Шаг 2. Сгенерируйте API-ключ

Для создания персонального API-ключа:

На верхней панели слева нажмите

и перейдите в раздел Пользователи, на вкладку Сервисные аккаунты.

Нажмите на название сервисного аккаунта, который будете использовать для отправки запроса к модели.

В разделе Учетные данные доступа нажмите Создать API-ключ.

Введите название и описание API-ключа, которое поможет в будущем идентифицировать его среди других ключей.

Заполните параметры API-ключа:

Сервисы — Foundation Models.

Время действия — срок действия API-ключа и часовой пояс. Вы можете установить значение от одного дня до одного года с текущей даты. Если параметр не задан, срок действия ключа устанавливается на максимальное значение — один год. Из соображений безопасности рекомендуется выставлять средние значения, например 90 дней.

Интервал работы ключа — один или несколько интервалов времени, в которые можно использовать API-ключ.

Нажмите Создать.

Сохраните Key Secret. После закрытия окна получить его будет нельзя.

Созданный API-ключ появится в списке ключей в статусе «Активен». Подробнее о работе с API-ключом.

Шаг 3. Отправьте запрос к модели

Для отправки запроса к модели:

Выберите модель, например, GigaChat3-10B-A1.8B. Подробнее о доступных моделях.

Нажмите Использовать.

Сохраните сгенерированный API-ключ в переменную окружения API_KEY.

Установите библиотеку openai:

pip install openaiСкопируйте код для отправки запроса, нажав Копировать код.

Вставьте код в ваше приложение, предварительно при необходимости скорректировав параметры:

max_tokens — максимальное количество токенов в ответе.

temperature — параметр, влияющий на креативность ответа.

presence_penalty и top_p — параметры, влияющие на вероятность выбора токенов.

messages — роль и содержимое запроса к модели.

Запрос при помощи библиотеки openai на стандартный эндпоинт, содержащий chat.completions из спецификации OpenAI.

import osfrom openai import OpenAIapi_key = os.environ["API_KEY"]url = "https://foundation-models.api.cloud.ru/v1"client = OpenAI(api_key=api_key,base_url=url)response = client.chat.completions.create(model="ai-sage/GigaChat3-10B-A1.8B",max_tokens=2500,temperature=0.5,presence_penalty=0,top_p=0.95,messages=[{"role": "user","content":"Как написать хороший код?"}])print(response.choices[0].message.content)

Где:

API_KEY — значение API-ключа, полученного на шаге 2.

Ниже описано, какие параметры использованы и почему выбраны конкретные значения:

temperature = 0.5 — баланс между детерминированностью (0) и креативностью (1). Значение 0.5 позволяет модели предлагать неочевидные аналогии, сохраняя техническую точность.

top_p = 0.95 — ограничивает выбор токенов до 90% наиболее вероятных вариантов. Позволяет избегать абсурдных ответов, сохраняя разнообразие.

max_tokens = 2500 — оптимальная длина для подробного объяснения без избыточности. Ограничивает размер ответа для быстрого получения результата.

frequency_penalty = 0.5 — снижает повторение одинаковых фраз: 0 — без штрафа, 2 — максимальный штраф. Помогает избегать зацикливания на одних и тех же формулировках.

presence_penalty = 0 — поощряет введение новых тем при отрицательном значении или фокусировку на текущем контексте.

Что дальше

Посмотрите пошаговые инструкции для работы с моделями.