С помощью этой инструкции можно создать Node Pool через консоль управления Advanced.

Перед началом работы

Войдите в консоль управления Advanced:

Создайте кластер CCE Standard или CCE Turbo.

В списке сервисов выберите Cloud Container Engine.

Нажмите на название кластера, в котором нужно создать Node Pool.

В меню слева выберите Nodes.

Нажмите Create Node Pool.

Шаг 1. Basic Settings

В поле Node Pool Name задайте название Node Pool.

Требования к названию:

От 1 до 50 символов.

Только строчные буквы, цифры и дефисы.

Начинается с буквы.

Не заканчивается дефисом.

После создания Node Pool название нельзя изменить.

Узлам внутри Node Pool будут присвоены названия, состоящие из названия Node Pool и пяти случайных символов.

В списке Enterprise Project выберите EPS-проект, в котором будет создан Node Pool.

Чтобы создать новый проект, нажмите Create Enterprise Project.

Шаг 2. Node Configuration

В блоке Node Type выберите виртуальные машины ECS Elastic Cloud Server (VM) в качестве узлов.

Выделенные серверы Elastic Cloud Server (physical machine) на данный момент недоступны.

В блоке Specifications выберите спецификацию узлов.

Доступные типы флейворов:

Ultra-high I/O (только для CCE Standard)

GPU-accelerated (только для CCE Standard)

Особенности:

Для кластеров CCE Turbo доступны только флейворы с поддержкой нескольких Elastic Network Interface (ENI).

Можно выбрать несколько флейворов, но только одного типа.

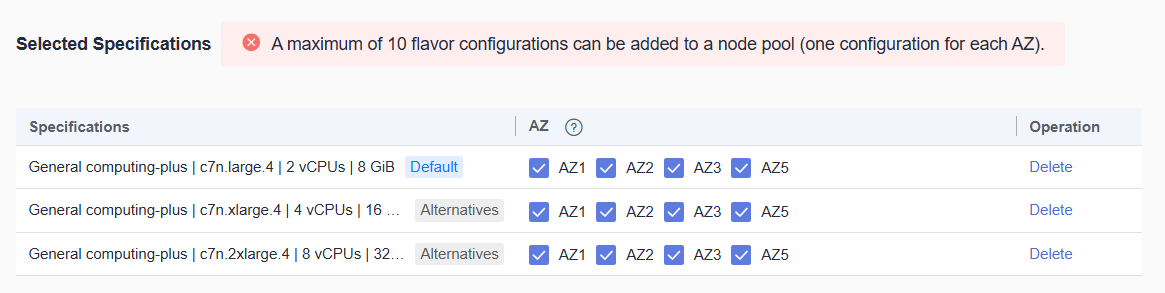

Максимальное количество флейворов в Node Pool — 10. Если для флейвора выбрано несколько зон доступности, каждая из них будет считаться отдельно. Например:

В примере выбрано три флейвора в четырех зонах доступности. Чтобы уложиться в ограничение максимального количество флейворов, достаточно отключить две зоны доступности у любых флейворов.

Узлы в только что созданном Node Pool создаются на основе флейвора по умолчанию (Default). Это тот флейвор, который вы отметите первым. Если ресурсов будет недостаточно, создание узла завершится ошибкой.

После создания Node Pool из него нельзя будет удалить выбранные флейворы.

В блоке Container Engine выберите среду выполнения контейнеров. CCE поддерживает Docker и containerd. Доступная для выбора среда зависит от типа кластера, его версии и операционной системы узлов.

Рекомендуется использовать containerd.

В блоке OS выберите операционную систему для узлов:

Public image — публичные образы.

Private image — приватные образы.

В блоке Login Mode выберите способ аутентификации на узлах:

Password — по паролю. Имя пользователя по умолчанию — root.

Требования к паролю:

От 8 до 26 символов.

Содержит символы как минимум трех типов: заглавные буквы, строчные буквы, цифры и специальные символы (!, @, $, %, ^, -, _, =, +, [, ], {, }, :, ,, ., /, ?).

Не повторяет имя пользователя в прямом и обратном порядке. Например, root — toor.

Задайте и подтвердите пароль в соответствующих полях.

Key Pair — по ключу.

В списке Key Pair выберите существующую пару ключей. Чтобы создать новую, нажмите Create a Key Pair.

Подтвердите соглашение «I acknowledge that I have obtained private key file KeyPair-name required to log in to the node».

Шаг 3. Storage Settings

В поле System Disk выберите тип диска для операционной системы узла и задайте его размер.

Доступные типы дисков:

High I/O

Ultra-high I/O

Extreme SSD

О размере диска:

Допустимый размер: 40–1 024 ГиБ.

Значение по умолчанию: 50 ГиБ.

В поле Data Disk настройте диски для контейнеров и приложений на узле.

На узле должен быть минимум один Data Disk для среды выполнения контейнеров и kubelet. Это первый диск в списке. Его нельзя удалить во время создания Node Pool. Удаление уже существующего диска приведет к недоступности соответствующего узла.

В раскрывающемся блоке Expand можно выполнить дополнительные настройки:

Data Disk Space Allocation — распределение дискового пространства для сред выполнения контейнеров, образов и временного хранилища для их корректной работы.

Data Disk Encryption — шифрование диска данных.

Настройки шифрования автоматически наследуются снапшотами и дисками, созданными на основе снапшотов.

Вы можете добавить дополнительные диски данных, но не более 16 вместе с обязательным. Для этого нажмите Add.

Дополнительные диски по умолчанию будут созданы в виде RAW-дисков без обработки. В раскрывающемся блоке Expand можно настроить параметры монтирования (Mount Settings):

Default — значение по умолчанию. RAW без дополнительной обработки.

Mount Disk — смонтировать диск в определенный каталог. Укажите нужный каталог в поле Mount Path. Это поле не может быть пустым.

Каталоги, в которые нельзя смонтировать дискUse as PV — использовать диск как Persistent Volume. Подходит в сценариях с высокими требованиями к производительности PV.

К узлу с настроенным PV будет добавлена метка node.kubernetes.io/local-storage-persistent.

Use as ephemeral volume — использовать диск как Ephemeral Volume. Подходит в сценариях с высокими требованиями к производительности emptyDir.

Размеры Data Disk:

Допустимый размер первого диска: 20–32 768 ГиБ.

Допустимый размер последующих дисков: 10–32 768 ГиБ.

Значение по умолчанию для всех дисков: 100 ГиБ.

Шаг 4. Network Settings

В поле VPC/Node Subnet выберите подсеть для узла. По умолчанию используется подсеть, которая была выбрана при создании кластера.

Сеть VPC изменить нельзя. Узлы будут в той же сети, в которой находится кластер.

В поле Node IP доступен только автоматический способ назначения IP-адресов узлам — Automatic.

В поле Associate Security Groups выберите группы безопасности для узлов. Правила выбранных групп безопасности распространяются на все узлы в Node Pool.

По умолчанию выбрана группа безопасности, созданная автоматически при создании кластера. Она отмечена как Default. Шаблон названия: {Название кластера}-cce-node-{Случайный идентификатор}.

Если вы хотите выбрать другую группу безопасности, убедитесь, что в ней есть правила, необходимые для взаимодействия узлов между собой. Подробнее о настройке правил (en).

Когда Node Pool будет создан, назначенные группы безопасности нельзя будет изменить.

Шаг 5. (Optional) Advanced Settings

В блоке (Optional) Advanced Settings находятся расширенные настройки Node Pool. При необходимости выполните эти настройки:

Раскройте блок (Optional) Advanced Settings.

В блоке Resource Tag добавьте теги для классификации облачных ресурсов. Вы можете создать и присвоить собственные теги — Predefined Tags.

Независимо от наличия собственных тегов, каждому узлу в Node Pool будет автоматически присвоен тег с ключом CCE-Dynamic-Provisioning-Node, в качестве значения которого будет указан идентификатор узла.

Максимальное количество тегов — 8.

В блоке Kubernetes Label добавьте метки Kubernetes. Максимальное количество меток — 20.

В блоке Taint задайте taint-политики для узлов. Они позволяют запретить размещение определенных подов на определенных узлах.

Введите ключ и значение в соответствующие поля, а затем выберите эффект, оказываемый политикой:

NoSchedule — не размещать новые поды на узлах с этой политикой, если нет исключения в виде Toleration. Существующие поды продолжат работу.

PreferNoSchedule — не размещать поды на узлах с этой политикой, если ресурсы есть на других узлах.

NoExecute— не запускать новые поды на узлах с этой политикой. Существующие поды будут завершены и распределены на другие узлы.

В блоке Synchronization for Existing Nodes настройте синхронизацию изменений тегов (Tags), меток (Labels) и Taint-политик с существующими узлами в Node Pool.

В блоке New Node Scheduling настройте политику планирования новых узлов в Node Pool.

Опция Unschedulable позволяет помечать новые узлы в Node Pool как unschedulable. На узлы с такой меткой новые поды назначаться не будут. Это позволит выполнить дополнительные настройки на узлах до назначения подов на них.

Если вы включили опцию Unschedulable, дополнительно настройте параметр Scheduled Scheduling. Он отвечает за то, когда узлы станут доступны для планирования подов. Доступные варианты:

Disabled — оставляет узлы недоступными для планирования, пока обратное не будет задано другим способом.

Custom — позволяет установить таймаут, после которого узлы станут доступны для планирования подов на них. Допустимое значение: 0–99 минут.

ПримечаниеЕсли требуется автоматическое масштабирование (en), убедитесь, что период недоступности узлов для планирования составляет меньше 15 минут. Если узел, добавленный с помощью Autoscaler, недоступен для планирования дольше 15 минут, Autoscaler посчитает, что масштабирование не удалось, и повторно запустит масштабирование. Если узел будет недоступен для планирования дольше 20 минут, он будет удален.

С опцией Unschedulable узлы на время создания или обновления будут помечаться Taint-меткой node.cloudprovider.kubernetes.io/uninitialized.

В поле Max. Pods задайте максимальное количество подов, которые могут быть запущены на узле. Это ограничение предотвращает перегрузку узла.

Возможные значения: 16–256. Максимальное количество зависит от нескольких факторов. Подробнее о максимальном количестве подов на узле (en).

В поле ECS Group можно настроить объединение виртуальных машин в группы. Виртуальные машины внутри группы объединены одной политикой распределения по физическим серверам.

На данный момент в ECS Group доступна только политика Anti-affinity. С этой политикой ECS будут разворачиваться на разных физических серверах.

Включите опцию ECS Group и выберите ECS-группу из списка. Если нужно создать новую группу, нажмите Add ECS Group.

В поле Pre-installation Command добавьте скрипт, который будет выполнен на узле перед установкой Kubernetes. Ошибки в скрипте могут привести к тому, что установка Kubernetes завершится с ошибкой.

Количество символов в полях Pre-installation Command и Post-installation Command суммируется и не должно превышать 10 240.

В поле Post-installation Command добавьте скрипт, который будет выполнен на узле после установки Kubernetes.

ВниманиеНе используйте команду reboot для перезагрузки системы. Если нужна перезагрузка, используйте shutdown -r 1. В этом случае система будет перезагружена с задержкой в одну минуту.

В поле Agency выберите агентство.

Агентства позволяют делиться облачными ресурсами с другой учетной записью или доверить управление своими ресурсами другому сотруднику или команде.

Чтобы создать новое агентство, нажмите Create Agency.

Чтобы к названию узлов в Node Pool добавлялись префикс и суффикс, включите опцию Custom Prefix and Suffix и введите их в соответствующие поля.

Ограничения:

Префикс и суффикс нельзя изменить после создания Node Pool.

Допустимые символы: строчные буквы, цифры и специальные символы - и ..

Два подряд специальных символа в любом порядке недопустимы.

Префикс может заканчиваться специальным символом, а суффикс начинаться.

Название узла может содержать не более 56 символов с учетом префикса и суффикса.

В блоке Kubernetes Node Name выберите значение, которое будет присвоено метке metadata.labels.kubernetes.io/hostname в YAML-файле узла:

Node private IP — приватный IP-адрес узла.

Cloud server name — название виртуальной машины ECS. Названия ECS могут повторяться, поэтому CCE автоматически добавит к нему пять случайных символов.

Шаг 6. Confirm

Нажмите Next: Confirm.

Проверьте конфигурацию Node Pool и подтвердите соглашение «I have read and understand the preceding instructions».

Чтобы создать Node Pool, нажмите Submit.

Node Pool будет создан почти моментально и сразу появится на вкладке Node Pools со статусом «Normal».