Для запуска SupaBase необходимо:

Настройка кластера Docker Swarm

Для настройки нужно подключиться к первому серверу, созданному для хостинга SupaBase:

Подключение первой виртуальной машины SupaBase

Войдите в консоль управления Advanced:

В списке сервисов выберите Elastic Cloud Server.

Выберите первый бэкенд-сервер, созданный для SupaBase, и нажмите Remote login.

В консоли сервера введите:

Логин пользователя — root.

Пароль, который был указан при создании виртуальной машины.

Нажмите Enter.

Для установки docker построчно выполните команды:

sudo apt updatecurl -fsSL https://get.docker.com -o get-docker.shsudo sh get-docker.shsudo docker swarm init --advertise-addr $(ip route get 8.8.8.8 | head -1 | cut -d' ' -f7)

Подключение второй виртуальной машины SupaBase

Теперь нужно добавить вторую виртуальную машину в docker swarm:

Войдите в консоль управления Advanced:

В списке сервисов выберите Elastic Cloud Server.

Выберите второй бэкенд-сервер, созданный для SupaBase, и нажмите Remote login.

В консоли сервера введите:

Логин пользователя — root.

Пароль, который был указан при создании виртуальной машины.

Нажмите Enter.

Построчно выполните команды:

sudo apt updatecurl -fsSL https://get.docker.com -o get-docker.shsudo sh get-docker.sh

Подключение к Docker Swarm

Войдите в консоль управления Advanced:

В списке сервисов выберите Elastic Cloud Server.

В списке виртуальных машин ECS выберите первый бэкенд-сервер и скопируйте его Private IP, нажав

.

.В команде ниже замените:

<пароль> — на пароль root-пользователя, указанный при создании виртуальной машины.

<ip-адрес> — на скопированный адрес Private IP.

ssh root:<пароль>@<ip адрес> "docker swarm join-token worker" | grep -E "docker" | shВыполните эту команду на втором бэкенд-сервере. В процессе выполнения необходимо согласиться с подключением к первому серверу и ввести его пароль.

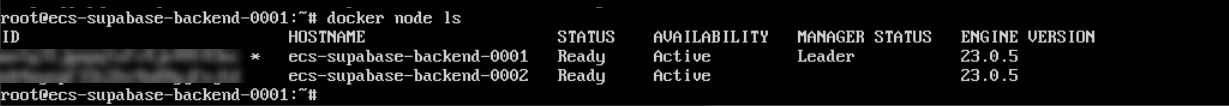

Для проверки подключения перейдите к первому бэкенд-серверу и выполните команду:

docker node lsПри успешном выполнении отобразится два сервера.

Запуск SupaBase в Docker Swarm

Указанные конфигурации не должны применяться в продуктивных средах по следующим причинам:

Используются ключи-примеры, которые должны быть отдельно сформированы для каждой среды.

Отсутствует подключение к почтовому серверу.

Используется простой пароль для Postgres.

Используется простой секрет для JWT.

Подробности на сайте supabase.com.

После того, как виртуальные машины настроены, можно выполнить развертывание SupaBase:

В списке сервисов выберите Elastic Cloud Server.

Выберите бэкенд-сервер и нажмите Remote login.

В консоли сервера введите логин и пароль, если необходимо.

Скачайте необходимые файлы. Команды выполняются построчно:

git clone --depth 1 https://github.com/supabase/supabasecd supabase/dockertouch .envСоздайте файл с переменными. Для этого копируйте команду целиком:

ВниманиеПеред копирование замените адрес <IP-адрес балансировщика> на ваш внешний IP-адрес (EIP) созданного балансировщика нагрузки.

cat <<EOT >> .envPOSTGRES_PASSWORD=MyStrongPasswordJWT_SECRET=your-super-secret-jwt-token-with-at-least-32-characters-longANON_KEY=j8eAMouA15uA0VHPZeicNWa7SLSERVICE_ROLE_KEY=i7uOAouA15uA0VHPYioaSQt4KNPOSTGRES_HOST=dbPOSTGRES_DB=postgresPOSTGRES_USER=postgresPOSTGRES_PORT=5432KONG_HTTP_PORT=8000KONG_HTTPS_PORT=8443PGRST_DB_SCHEMAS=public,storage,graphql_publicSITE_URL=http://<IP-адрес балансировщика>:3000ADDITIONAL_REDIRECT_URLS=JWT_EXPIRY=3600DISABLE_SIGNUP=falseAPI_EXTERNAL_URL=http://<IP-адрес балансировщика>:8000MAILER_URLPATHS_CONFIRMATION="/auth/v1/verify"MAILER_URLPATHS_INVITE="/auth/v1/verify"MAILER_URLPATHS_RECOVERY="/auth/v1/verify"MAILER_URLPATHS_EMAIL_CHANGE="/auth/v1/verify"ENABLE_EMAIL_SIGNUP=trueENABLE_EMAIL_AUTOCONFIRM=trueSMTP_ADMIN_EMAIL=admin@example.comSMTP_HOST=fakeserver.comSMTP_PORT=25SMTP_USER=userSMTP_PASS=passwordSMTP_SENDER_NAME=fake_senderENABLE_PHONE_SIGNUP=falseENABLE_PHONE_AUTOCONFIRM=falseSTUDIO_DEFAULT_ORGANIZATION=Default OrganizationSTUDIO_DEFAULT_PROJECT=Default projectSTUDIO_PORT=3000PUBLIC_REST_URL=http://<IP-адрес балансировщика>:8000/rest/v1/EOTОбновите файл docker-compose.yml.

Откройте файл для редактирования:

nano docker-compose.ymlУберите все содержимое файла и вставьте код:

ПримечаниеРекомендуется использовать окно Input Commands несколько раз, так как файл достаточно длинный. Также важно сохранить отступы.

version: "3.8"services:studio:container_name: supabase-studioimage: supabase/studio:0.22.08restart: unless-stoppedports:- ${STUDIO_PORT}:3000/tcpenvironment:STUDIO_PG_META_URL: http://meta:8080POSTGRES_PASSWORD: ${POSTGRES_PASSWORD}DEFAULT_ORGANIZATION: ${STUDIO_DEFAULT_ORGANIZATION}DEFAULT_PROJECT: ${STUDIO_DEFAULT_PROJECT}SUPABASE_URL: http://kong:8000SUPABASE_REST_URL: ${PUBLIC_REST_URL}SUPABASE_ANON_KEY: ${ANON_KEY}SUPABASE_SERVICE_KEY: ${SERVICE_ROLE_KEY}kong:container_name: supabase-kongimage: kong:2.8.1restart: unless-stoppedports:- ${KONG_HTTP_PORT}:8000/tcp- ${KONG_HTTPS_PORT}:8443/tcp- 8001:8001/tcpenvironment:KONG_DATABASE: "off"KONG_ADMIN_LISTEN: "0.0.0.0:8001"KONG_DECLARATIVE_CONFIG: /var/lib/kong/kong.yml# https://github.com/supabase/cli/issues/14KONG_DNS_ORDER: LAST,A,CNAMEKONG_PLUGINS: request-transformer,cors,key-auth,aclKONG_NGINX_PROXY_PROXY_BUFFER_SIZE: 160kKONG_NGINX_PROXY_PROXY_BUFFERS: 64 160kvolumes:- /mnt/sfs_turbo/volumes/api:/var/lib/kong:roauth:container_name: supabase-authimage: supabase/gotrue:v2.19.4restart: unless-stoppedenvironment:GOTRUE_API_HOST: 0.0.0.0GOTRUE_API_PORT: 9999API_EXTERNAL_URL: ${API_EXTERNAL_URL}GOTRUE_DB_DRIVER: postgresGOTRUE_DB_DATABASE_URL: postgres://supabase_auth_admin:${POSTGRES_PASSWORD}@${POSTGRES_HOST}:${POSTGRES_PORT}/${POSTGRES_DB}GOTRUE_SITE_URL: ${SITE_URL}GOTRUE_URI_ALLOW_LIST: ${ADDITIONAL_REDIRECT_URLS}GOTRUE_DISABLE_SIGNUP: ${DISABLE_SIGNUP}GOTRUE_JWT_ADMIN_ROLES: service_roleGOTRUE_JWT_AUD: authenticatedGOTRUE_JWT_DEFAULT_GROUP_NAME: authenticatedGOTRUE_JWT_EXP: ${JWT_EXPIRY}GOTRUE_JWT_SECRET: ${JWT_SECRET}GOTRUE_EXTERNAL_EMAIL_ENABLED: ${ENABLE_EMAIL_SIGNUP}GOTRUE_MAILER_AUTOCONFIRM: ${ENABLE_EMAIL_AUTOCONFIRM}GOTRUE_SMTP_ADMIN_EMAIL: ${SMTP_ADMIN_EMAIL}GOTRUE_SMTP_HOST: ${SMTP_HOST}GOTRUE_SMTP_PORT: ${SMTP_PORT}GOTRUE_SMTP_USER: ${SMTP_USER}GOTRUE_SMTP_PASS: ${SMTP_PASS}GOTRUE_SMTP_SENDER_NAME: ${SMTP_SENDER_NAME}GOTRUE_MAILER_URLPATHS_INVITE: ${MAILER_URLPATHS_INVITE}GOTRUE_MAILER_URLPATHS_CONFIRMATION: ${MAILER_URLPATHS_CONFIRMATION}GOTRUE_MAILER_URLPATHS_RECOVERY: ${MAILER_URLPATHS_RECOVERY}GOTRUE_MAILER_URLPATHS_EMAIL_CHANGE: ${MAILER_URLPATHS_EMAIL_CHANGE}GOTRUE_EXTERNAL_PHONE_ENABLED: ${ENABLE_PHONE_SIGNUP}GOTRUE_SMS_AUTOCONFIRM: ${ENABLE_PHONE_AUTOCONFIRM}rest:container_name: supabase-restimage: postgrest/postgrest:v9.0.1.20220717restart: unless-stoppedenvironment:PGRST_DB_URI: postgres://authenticator:${POSTGRES_PASSWORD}@${POSTGRES_HOST}:${POSTGRES_PORT}/${POSTGRES_DB}PGRST_DB_SCHEMAS: ${PGRST_DB_SCHEMAS}PGRST_DB_ANON_ROLE: anonPGRST_JWT_SECRET: ${JWT_SECRET}PGRST_DB_USE_LEGACY_GUCS: "false"realtime:container_name: supabase-realtimeimage: supabase/realtime:v0.25.1restart: unless-stoppedenvironment:DB_HOST: ${POSTGRES_HOST}DB_PORT: ${POSTGRES_PORT}DB_NAME: ${POSTGRES_DB}DB_USER: supabase_adminDB_PASSWORD: ${POSTGRES_PASSWORD}DB_SSL: "false"PORT: 4000JWT_SECRET: ${JWT_SECRET}REPLICATION_MODE: RLSREPLICATION_POLL_INTERVAL: 100SECURE_CHANNELS: "true"SLOT_NAME: supabase_realtime_rlsTEMPORARY_SLOT: "true"command: >bash -c "./prod/rel/realtime/bin/realtime eval Realtime.Release.migrate&& ./prod/rel/realtime/bin/realtime start"storage:container_name: supabase-storageimage: supabase/storage-api:v0.21.4depends_on:- restrestart: unless-stoppedenvironment:ANON_KEY: ${ANON_KEY}SERVICE_KEY: ${SERVICE_ROLE_KEY}POSTGREST_URL: http://rest:3000PGRST_JWT_SECRET: ${JWT_SECRET}DATABASE_URL: postgres://supabase_storage_admin:${POSTGRES_PASSWORD}@${POSTGRES_HOST}:${POSTGRES_PORT}/${POSTGRES_DB}FILE_SIZE_LIMIT: 52428800STORAGE_BACKEND: fileFILE_STORAGE_BACKEND_PATH: /var/lib/storageTENANT_ID: stubREGION: stubGLOBAL_S3_BUCKET: stubvolumes:- /mnt/sfs_turbo/volumes/storage:/var/lib/storagemeta:container_name: supabase-metaimage: supabase/postgres-meta:v0.50.2restart: unless-stoppedenvironment:PG_META_PORT: 8080PG_META_DB_HOST: ${POSTGRES_HOST}PG_META_DB_PORT: ${POSTGRES_PORT}PG_META_DB_NAME: ${POSTGRES_DB}PG_META_DB_USER: supabase_adminPG_META_DB_PASSWORD: ${POSTGRES_PASSWORD}db:container_name: supabase-dbimage: supabase/postgres:14.1.0.82healthcheck:test: pg_isready -U postgres -h localhostinterval: 5stimeout: 5sretries: 10command:- postgres- -c- config_file=/etc/postgresql/postgresql.conf- -c- log_min_messages=fatal # prevents Realtime polling queries from appearing in logsrestart: unless-stoppedports:- ${POSTGRES_PORT}:5432environment:POSTGRES_HOST: /var/run/postgresqlPOSTGRES_PASSWORD: ${POSTGRES_PASSWORD}volumes:- /mnt/sfs_turbo/volumes/db/roles.sql:/docker-entrypoint-initdb.d/roles.sql- /mnt/sfs_turbo/volumes/postgres:/var/lib/postgresql/dataСохраните изменения, нажав Ctrl + O.

Подготовьте папки для хранения данных.

mkdir /mnt/sfs_turbo/volumes/mkdir /mnt/sfs_turbo/volumes/apimkdir /mnt/sfs_turbo/volumes/storagemkdir /mnt/sfs_turbo/volumes/dbmkdir /mnt/sfs_turbo/volumes/postgrescp volumes/db/roles.sql /mnt/sfs_turbo/volumes/dbcp volumes/api/kong.yml /mnt/sfs_turbo/volumes/apiЗапустите SupaBase.

set -a && . .env && set +adocker stack deploy --compose-file docker-compose.yml supabase

Почему файл docker-compose не используется из репозитория Supabase на github?

Так как система разворачивается на нескольких серверах, контейнеры должны иметь возможность работать с одними и теми же файлами на системе вне зависимости от сервера, на котором они запущены. Для этого была смонтирована SFS в качестве единой файловой системы и обновлен файл docker-compose, чтобы контейнеры ее использовали.

Публикация SupaBase через балансировщик

После запуска SupaBase на кластере из двух серверов его необходимо опубликовать, чтобы приложения могли его использовать.

В рабочей среде не рекомендуется публиковать сервис «Studio» наружу, так как он не защищен логином и паролем. Рекомендуется использовать доступ через VPN или публиковать через отдельный сервер с аутентификацией.

Если в файле docker-compose.yml были изменены номера портов, необходимо подставить использованные значения при выполнении инструкций.

- Для публикации нескольких сервисов:

Studio — веб-интерфейс управления, работает на порту 3000.

Kong — встроенный API-gateway, работает на порту 8000.

Так как разные сервисы работают на разных портах внутри виртуальных машин, то нужно создать несколько Backend Server Group и несколько Listener, по одной паре на публикуемый сервис.

Создание объектов для сервиса Studio

Войдите в консоль управления Advanced:

В списке сервисов выберите Elastic Load Balance.

Нажмите на название ранее созданного балансировщика.

На вкладке Backend Server Groups нажмите Add Backend Server Group.

Заполните параметры группы серверов:

Name — название группы серверов.

Backend protocol — HTTP.

Port — 3000.

Нажмите OK.

В правой части экрана нажмите Add.

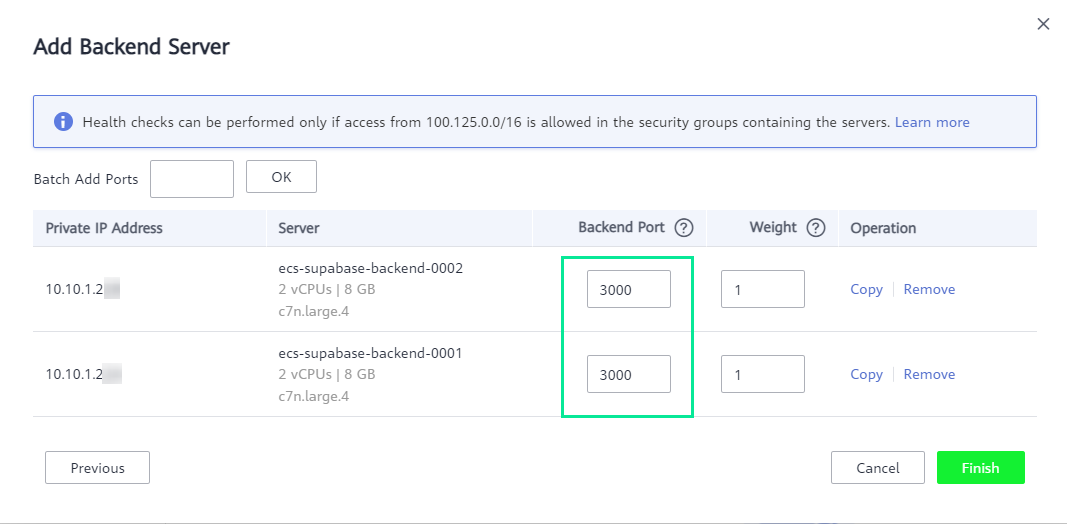

В открывшемся окне выберите два сервера, созданных для Supabase и нажмите Next.

В качестве порта Backend Port укажите 3000 и нажмите Finish.

На вкладке Listeners нажмите Add Listener.

Заполните параметры группы серверов:

Name — название создаваемого listner.

Frontend protocolPort — HTTP.

Port — 3000.

Нажмите Next.

Настройте группу серверов, для этого:

Backend Server Group — укажите Use existing.

В выпадающем списке выберите ранее созданную группу.

Нажмите Finish.

Создание объектов для сервиса Kong

Повторите действия по созданию объектов Studio для публикации Kong: создание группы серверов и listener.

Нажмите на название ранее созданного балансировщика.

На вкладке Backend Server Groups нажмите Add Backend Server Group.

Заполните параметры группы серверов:

Name — название создаваемого listner. Рекомендуется в названии указать «kong-» для удобства.

Frontend protocolPort — TCP.

Port — 8000.

Health Check Configuration — для проверки работоспособности используйте порт TCP — 8001 (интерфейс администратора).

Нажмите OK.

В правой части экрана нажмите Add.

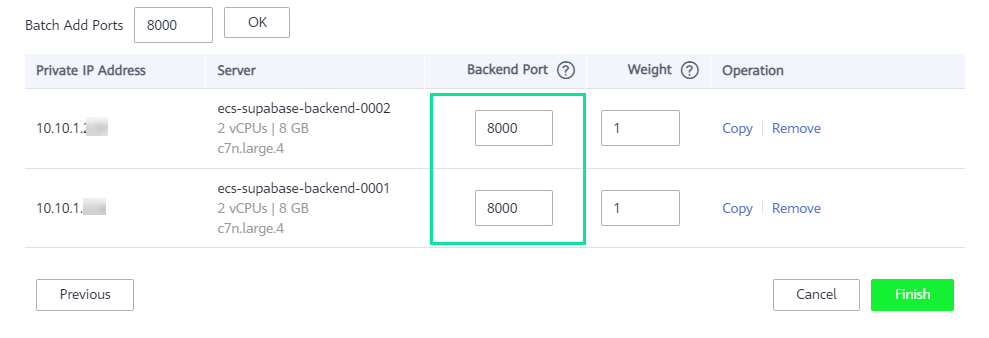

В открывшемся окне выберите два сервера, созданных для Supabase и нажмите Next.

В качестве порта Backend Port укажите 8000 и нажмите Finish.

- Для проверки корректной настройки выполните:

На странице балансировщика откройте вкладку Basic information.

Скопируйте внешний IP-адрес (EIP) в поле IP Address, присвоенный балансировщику.

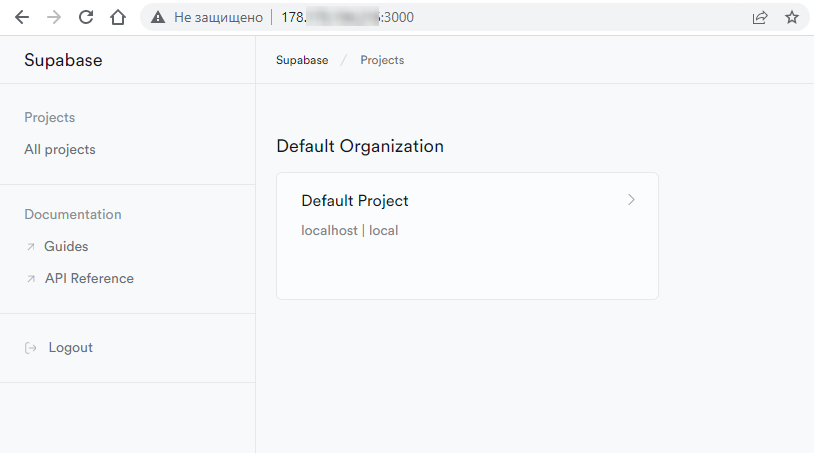

Откройте в браузере страницу:

http://<IP-адрес балансировщика>:3000/Если все настройки верны, то откроется интерфейс SupaBase.

Теперь перейдите к шагу развертывания тестового приложения, которое будет использовать BaaS (backend as a service).